与OpenAI分手之后,Figure自研首个模型终于交卷了!

不用ChatGPT,Figure直接把视觉-语言-动作模型(VLA)——Helix装入人形机器人大脑。

它可以让机器人感知、语言理解、学习控制,是一个端到端的通用模型。

果然,Figure的一大目标,就是发展家庭机器人。为此,其内部的AI需要像人一样推理,需要处理任何家庭用品。

「机器人若不实现能力上的飞跃,将无法进入家庭领域」

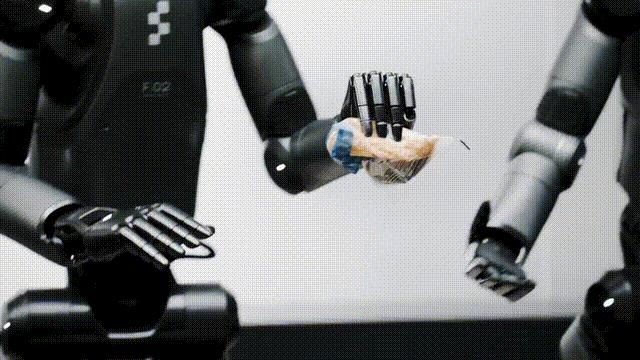

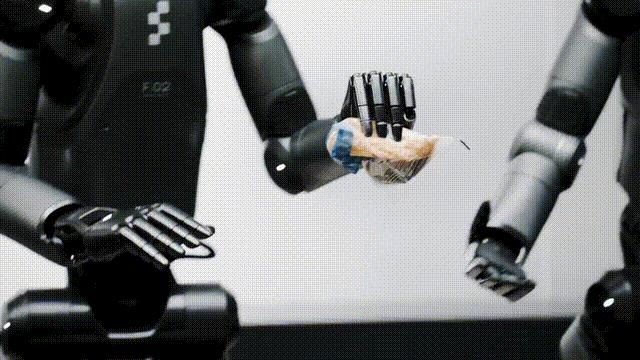

目前,Helix还主要用于Figure上半身控制,包括手腕、头、单个手指、甚至躯干,能以高速率执行复杂任务。

只需一句话,机器人便可以拿起任何物品。

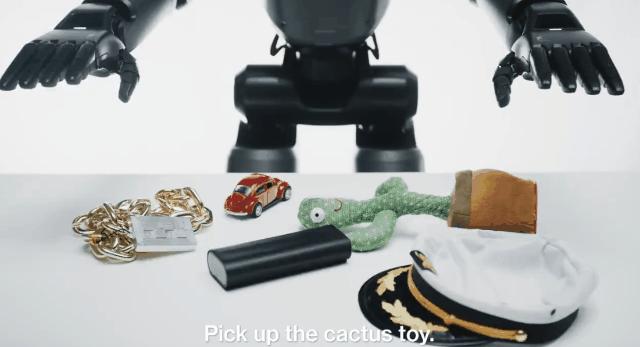

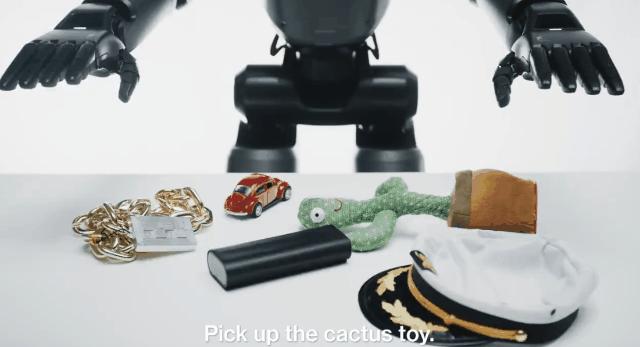

当被要求「捡起沙漠物品」时,Helix会识别出玩具仙人掌,选择最近的手,并执行精确的电机指令以牢固地抓住它。

还有生活中各种小物件,比如金属链、帽子、玩具等等,它皆精准「拿捏」。

快看,它还会将物品放置在冰箱,而且是两个Figure协作完成。

这是因为Helix是首个同时操控两台机器人的VLA,使他它们能够解决共同的、长序列操作任务,即使是处理从未见过的物品。

有网友表示,这一刻让我瞬间不寒而栗。

另有网友表示,「这非常令人印象深刻」,甚至有人马上想要买两台体验一下。

值得一提的是,新款模型采用单一神经网络权重学习所有行为,无需任何特定的微调。

而且,它还是首款完全在嵌入式低功耗GPU上运行的VLA,未来商业部署,甚至走入家庭近在咫尺。

Helix:通用视觉-语言-动作模型

家庭环境是机器人技术面临的最大挑战。

与可控的工业环境不同,家庭中充满了无数物品——易碎的玻璃器皿、褶皱的衣物、散落的玩具——每个物品都有着不可预测的形状、尺寸、颜色和质地。

要想让机器人在家庭中发挥作用,它们需要能够生成智能化的新行为来应对各种情况,特别是对于那些此前从未见过的物品。

如果没有质的飞跃,当前的机器人技术将无法适应家庭环境。

目前,仅仅教会机器人一个新行为就需要大量人力投入:要么需要博士级专家花费数小时进行手动编程,要么需要数千次示教。

考虑到家庭环境问题的庞大性,这两种方法的成本都高得难以承受。

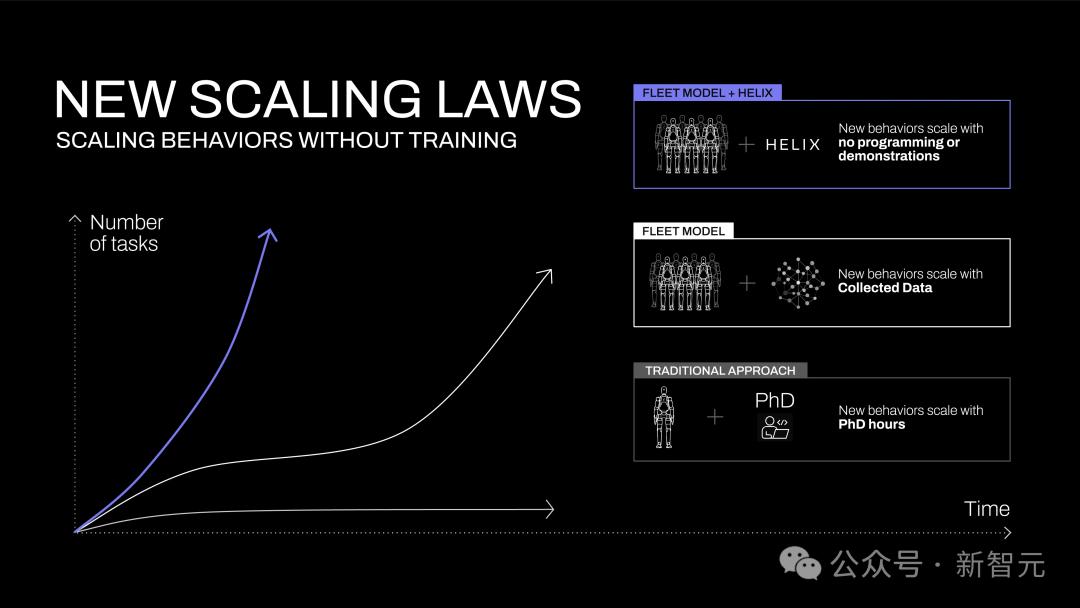

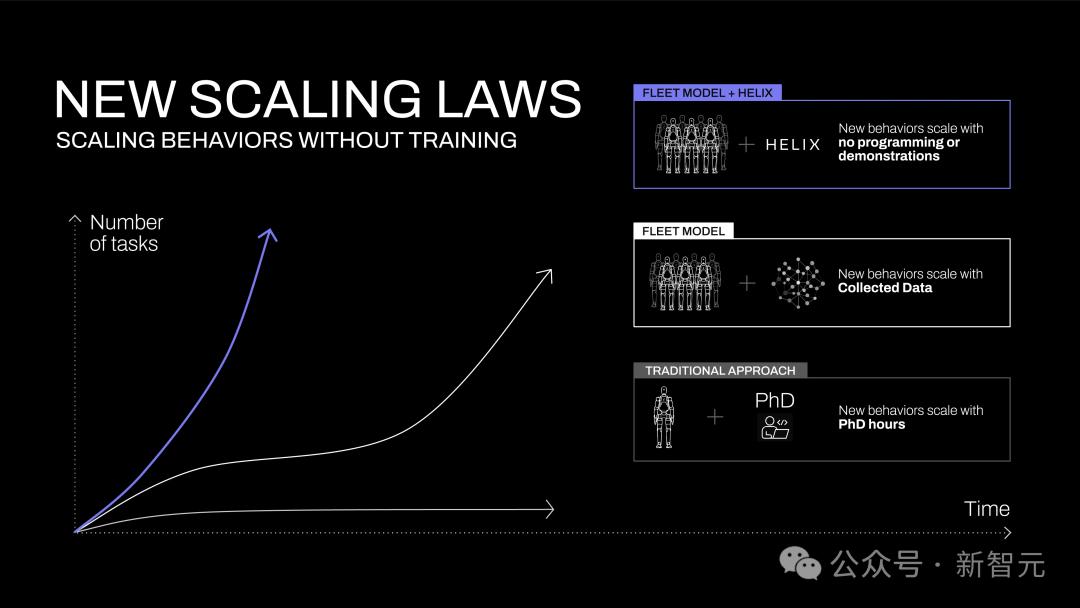

图1:不同机器人技能获取方法的扩展曲线。在传统启发式控制中,技能的增长取决于博士研究人员的手动编程。在传统机器人模仿学习中,技能随数据采集量扩展。而采用Helix技术,只需通过自然语言即可实时定义新技能

但在人工智能的其他领域已经掌握了即时泛化的能力。

如果我们能够将视觉语言模型(Vision Language Models,VLM)中捕获的丰富语义知识直接转化为机器人动作,将会带来什么改变?

这种新能力将从根本上改变机器人技术的发展轨迹(图1)。

突然间,那些曾经需要数百次示教才能掌握的新技能,现在只需通过自然语言与机器人对话就能立即获得。

关键问题在于:我们如何从VLM中提取所有这些常识知识,并将其转化为可泛化的机器人控制?Helix的构建正是为了跨越这一鸿沟。

首创「系统1,系统2」VLA

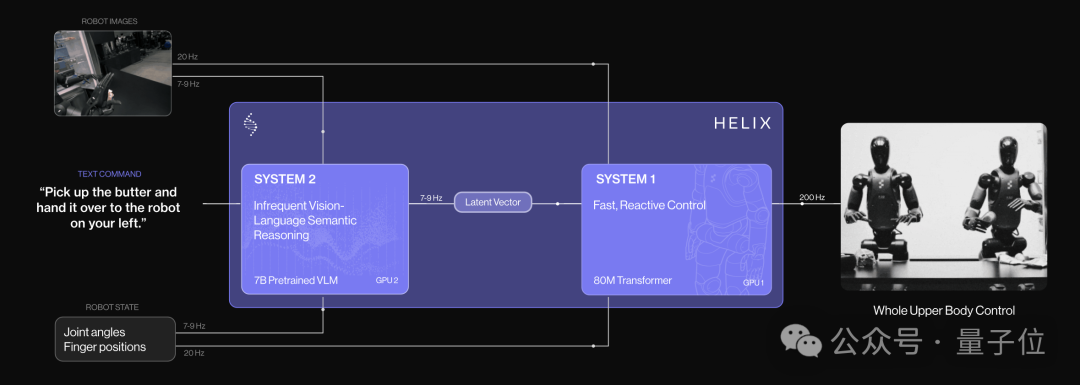

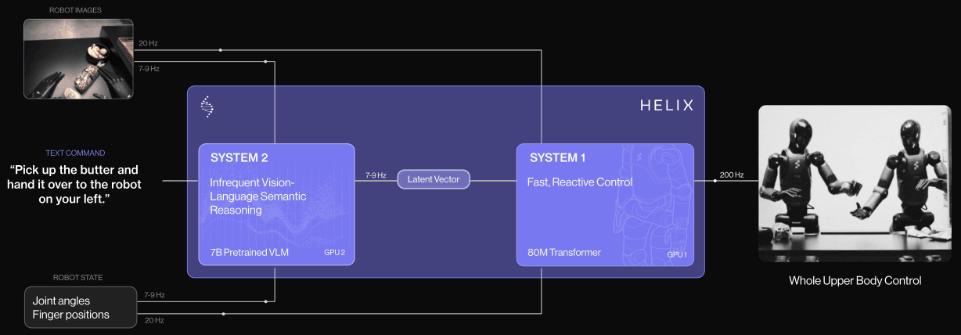

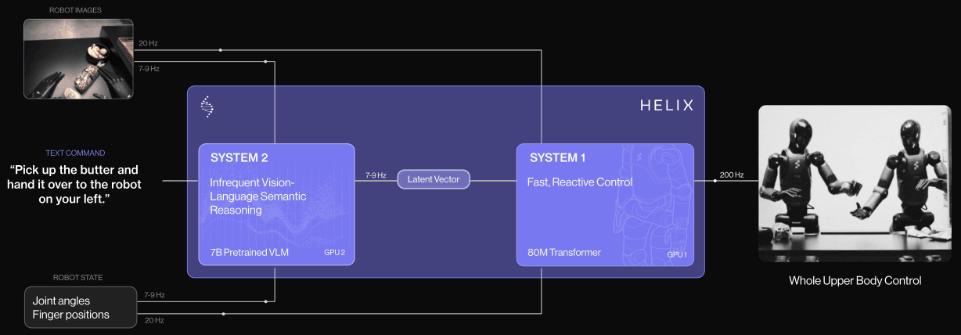

团队表示,Helix是首个由「系统1,系统2」组成的VLA,可以实现人形机器人上半身的高速精确控制。

先前的VLM主干网络具有通用性但速度不快,机器人视觉运动策略速度快但缺乏通用性。而Helix通过两个系统解决了这个难题,两个系统经过端到端训练,并可以相互通信:

系统2(S2):VLM主干网络,经互联网规模数据预训练,工作频率7-9Hz,用于场景和语言理解,可对不同的物体和场景进行泛化。

系统1(S1):80M参数交叉注意力Transformer,依靠一个全卷积的多尺度视觉主干网络进行视觉处理,该网络在模拟环境中完成预训练初始化。

这种解耦架构让每个系统都能在最佳时间尺度上运行,S2可以「慢思考」高层目标,S1通过「快思考」来实时执行和调整动作。

例如,在协作中,S1能快速适应伙伴机器人的动作变化,同时维持S2设定的语义目标。

Helix的设计相较现有方法具有以下几个关键优势:

速度和泛化能力:Helix不仅达到了专门针对单任务行为克隆(behavioral cloning)策略的运行速度,还能够对数千个全新测试对象实现零样本学习。

可扩展性:Helix能够直接输出高维动作空间的连续控制,避免了先前VLA方法中使用的复杂动作token化方案。这些方案虽然在低维控制设置(如二指夹爪)中取得了一定成功,但在高维人形机器人控制中面临扩展性挑战。

架构简单:Helix采用标准架构——系统2使用开源、开放权重的视觉语言模型,系统1则采用简单的基于Transformer的视觉运动策略。

职责分离:通过S1和S2的「解耦」,能够独立迭代优化每个系统,无需受限于寻找统一的观察空间或动作表示。

模型和训练细节

数据

研究人员收集了一个高质量的、多机器人、多操作员的多样化遥操作行为数据集,总计约500小时。

为了生成自然语言条件下的训练对,他们使用自动标注VLM来生成回顾性指令。

VLM会处理来自机器人板载摄像头的分段视频片段,提示词是这样的:「如果要实现视频中看到的动作,你会给机器人什么指令?」

为了防止数据干扰,所有训练中使用的物品都被排除在评估之外。

架构

这个系统主要包括两个主要组件,S2(VLM主干网络)和S1(基于潜层条件的视觉运动Transformer)。

S2建立在一个经过互联网规模数据预训练的7B参数开源开放权重VLM之上。它处理单目机器人图像和机器人状态信息(包括手腕姿态和手指位置),将这些信息投影到视觉-语言嵌入空间中。

结合指定期望行为的自然语言命令,S2会将所有与任务相关的语义信息提炼为单个连续潜层向量,传递给S1用于条件化其低层动作。

其中S1是一个80M参数的交叉注意力(cross-attention)编码器-解码器Transformer,负责低层控制。它依赖于一个全卷积的多尺度视觉主干网络进行视觉处理,该网络完全在模拟环境中预训练初始化。

虽然S1接收与S2相同的图像和状态输入,但它以更高的频率处理这些信息,以实现更快速的闭环控制。来自S2的潜层向量被投影到S1的token空间,并在序列维度上与S1视觉主干网络的视觉特征连接,提供任务条件。

S1以200Hz的频率输出完整的上半身人形机器人控制信号,包括期望的手腕姿态、手指弯曲和外展控制,以及躯干和头部方向目标。

另外,团队还在动作空间中,附加了一个合成的「任务完成百分比」动作,让Helix能预测自己的终止条件。这样,多个学习行为的序列化就更容易了。

训练

Helix采用完全端到端(end-to-end)的训练方式,将原始像素和文本命令映射到连续动作,使用标准回归损失。

梯度通过用于条件化S1行为的潜在通信向量从S1反向传播到S2,实现两个组件的联合优化。

Helix不需要任务特定的适配;它保持单一训练阶段和单一神经网络权重集,无需独立的动作输出头或每个任务的微调阶段。

在训练过程中,研究中还在S1和S2输入之间添加了时间延迟。这个延迟经过校准,以匹配S1和S2在部署推理延迟之间的差距,确保部署期间的实时控制要求在训练中得到准确反映。

优化的流式推理

因为这种训练设计,Helix就能在Figure机器人上进行高效的模型并行部署了,每个机器人都配备了双低功耗嵌入式GPU。

其中,推理流程在S2(高层潜规划)和S1(低层控制)模型之间分割,各自在专用GPU上运行。

S2作为异步后台进程运行,处理最新的观察数据(机载相机和机器人状态)和自然语言命令。它会持续更新共享内存中的潜在向量,用于编码高层行为意图。

而S1作为独立的实时进程执行,能维持平滑的整体上半身动作所需的关键200Hz控制循环。它会同时接收最新的观察数据和最近的S2潜在向量。

S2和S1推理之间固有的速度差异,自然会导致S1以更高的时间分辨率处理机器人观察数据,为响应式控制创建更紧密的反馈循环。

这种部署策略有意模仿训练中引入的时间延迟,最小化训练和推理之间的分布差异。异步执行模型允许两个进程以其最优频率运行,因此能以与最快的单任务模仿学习策略相当的速度运行Helix。

结果

精细化VLA全上半身控制

Helix以200Hz的频率协调35个自由度的动作空间,控制从单个手指运动到末端执行器(end-effector)轨迹、头部注视和躯干姿态的所有动作。

头部和躯干控制带来独特的挑战——当它们移动时,既会改变机器人的可达范围,也会改变它的可视范围,形成传统上容易导致系统不稳定的反馈循环。

机器人在调整躯干以获得最佳可达范围的同时,用头部平滑地跟踪其手部动作,并保持精确的手指控制以进行抓取。

从传统角度来看,即使对于单个已知任务,在如此高维(high-dimensional)的动作空间中实现这种精度一直被认为是极具挑战性的。

目前,还没有VLA系统能够在保持通用泛化能力(适用于不同任务和物体)的同时,展示出这种程度的实时协调控制。

零样本学习多机器人协调

研究人员在一个具有挑战性的多智能体(multi-agent)操作场景中将Helix推向极限:两台Figure机器人之间的协作式零样本学习杂货存储任务。

结果显示,机器人成功操作了在训练中从未见过的杂货,展示了对不同形状、尺寸和材料的强大通用泛化能力。

此外,两个机器人使用完全相同的Helix模型权重(model weights)运行,无需针对特定机器人的训练或明确的角色分配。

它们通过自然语言提示词来实现协调配合,比如「把饼干袋递给你右边的机器人」或「从你左边的机器人那里接过饼干袋并放入打开的抽屉中」。

这是首次使用VLA实现多机器人之间的灵活、持续性协作任务,而且机器人能够成功处理完全陌生的物体,这一成就具有重要的里程碑意义。

「任意物品拾取」能力涌现

研究人员发现配备Helix的Figure机器人只需一个简单的「拾取[X]」指令就能拾取几乎任何小型家居物品。

即使在杂乱的环境下,机器人也能成功处理从玻璃器皿和玩具到工具和衣物等数千件前所未见的物品,而这一切无需任何事先示范或定制编程。

值得注意的是,Helix成功地连接了大规模语言理解能力与精确的机器人控制系统。

例如,当接收到「拾取沙漠物品」这样的提示词时,Helix不仅能识别出玩具仙人掌符合这个抽象概念,还能选择最近的机械手臂并执行精确的运动指令(motor commands)来稳固抓取它。

这种通用的「语言到动作」抓取能力为类人机器人在复杂且不确定的非结构化环境中的部署开创了激动人心的可能性。

讨论

Helix的训练极其高效

Helix仅需极少的资源就实现了强大的物体识别和适应能力(物体泛化能力)。

研究人员总共使用了约500小时的高质量监督数据(supervised data)来训练Helix,这仅占此前收集的VLA数据集规模的一小部分(<5%),而且无需依赖多机器人实体数据收集或多阶段训练。

值得注意的是,这种数据收集规模更接近现代单任务模仿学习(imitation learning)数据集。尽管数据需求相对较小,Helix仍然可以扩展到更具挑战性的完整上肢人形机器人控制动作空间,成功实现高频率、高维度的输出控制。

统一的模型权重系统

现有的VLA系统通常需要专门的微调或专用的动作输出层来优化不同复杂行为的性能。

然而,Helix却能使用单一统一模型就实现了各种任务的出色表现。

仅使用一组神经网络权重(System 2使用70亿参数,System 1使用8千万参数),Helix就能够完成将物品放入各种容器、操作抽屉和冰箱、协调精确的多机器人交接,以及操作数千种全新物体等多样化任务。

结论

Helix是首个能够通过自然语言直接控制整个人形机器人上半身的视觉-语言-动作模型(Vision-Language-Action model)。

与早期的机器人系统相比,Helix能够实时完成持续性、需要配合的精密操作,而无需任何特定任务示范或大量手动编程。

Helix展现出卓越的物体适应能力,只需通过自然语言指令,就能拾取数千种在训练中从未接触过的家居物品,这些物品具有各种不同的形状、尺寸、颜色和材料特性。

这标志着Figure在拓展人形机器人行为能力方面取得了突破性进展——研究人员相信,随着机器人在日常家居环境中的应用日益广泛,这一进展将发挥重要的推动作用。

尽管这些初步成果令人振奋,但这仅仅是揭开了可能性的冰山一角。研究人员热切期待着将Helix的规模扩大至现有规模的千倍乃至更多时会带来怎样的突破。

参考资料:HNYZs

https://www.figure.ai/news/helix

来源:微信公众号“新智元”