1 简介

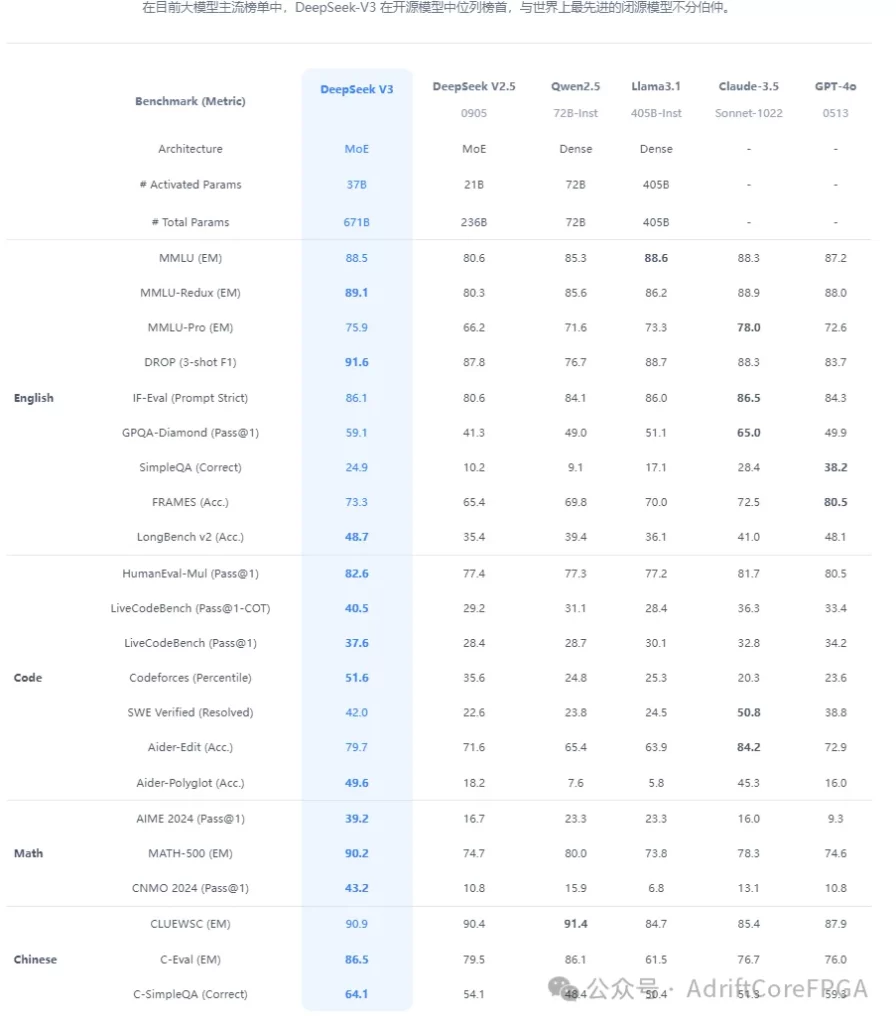

随着人工智能技术的飞速发展,大语言模型(Large Language Models, LLMs)逐渐从云端走向本地,为开发者、研究者和技术爱好者提供了更灵活、更私密的应用可能。国产DeepSeek 作为一款高效且功能强大的开源大模型,凭借其毫不逊色于Chatgpt的推理能力和对中文场景的深度适配,成为许多用户探索本地智能化的首选工具。

然而,对于非专业开发者或刚接触本地部署的用户而言,复杂的配置流程、环境依赖和资源管理往往令人望而却步。本文旨在通过极简的步骤、清晰的说明和实用的技巧,帮助小白用户在最短时间内完成从零部署的流程。

2 环境介绍

windows:win11

3 安装ollama

Ollama 是一个提供开源、简便且高效的工具平台,旨在使开发者能够在本地环境中运行和部署大型语言模型(LLMs)。Ollama 可以让用户轻松地运行一些主流的、开源的 LLM 模型,而无需依赖云服务,支持在本地服务器或个人计算机上进行推理任务。因此我们deepseek的载体就是ollama。

在官网下载ollama

https://ollama.com/

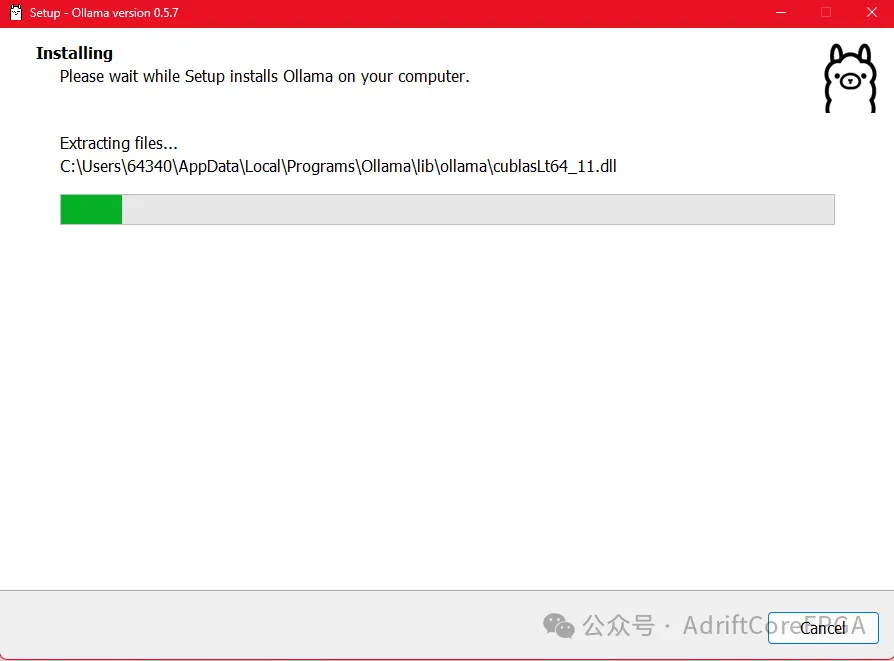

安装ollama

4 安装deepseek模型

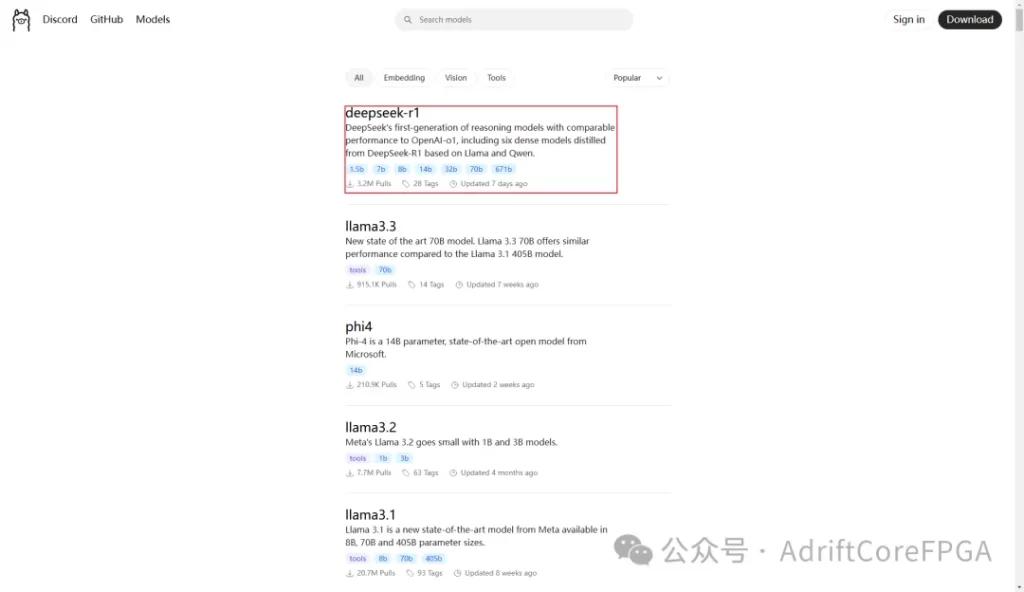

打开ollama官网,右上角models找到deepseek模型

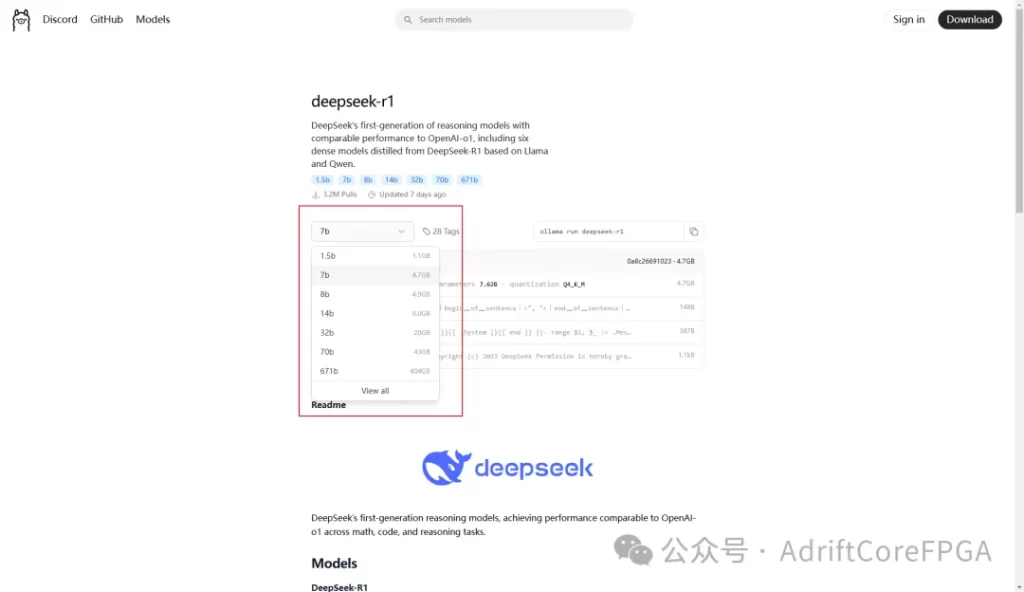

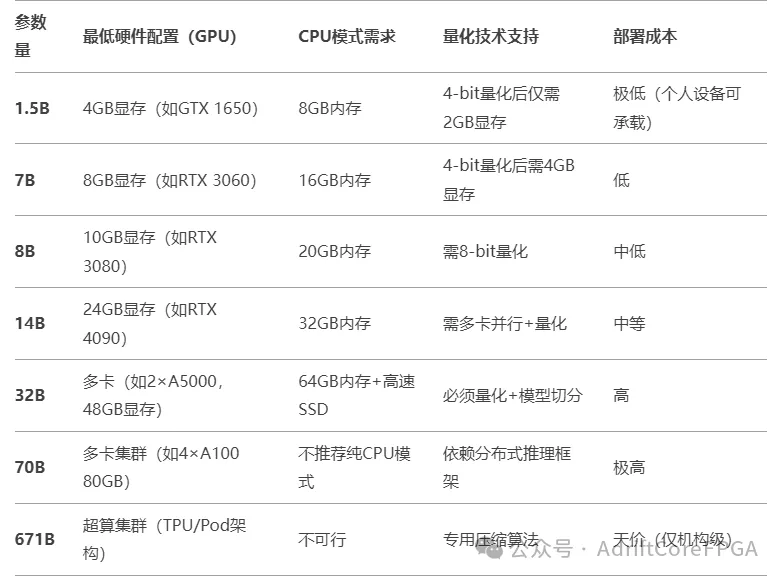

选择模型版本,在人工智能领域,模型名称中的 1.5B、7B、8B 等数字代表模型的参数量(Parameters),其中 B 是英文 Billion(十亿) 的缩写。参数越多,模型通常更“聪明”(能处理更复杂的任务),但对硬件资源(显存、内存)的要求也更高。个人用户可优先 7B(通用性最佳),若设备较弱则选 1.5B,开发者可选 8B。

以下是各版本的介绍

找到对应的命令,复制

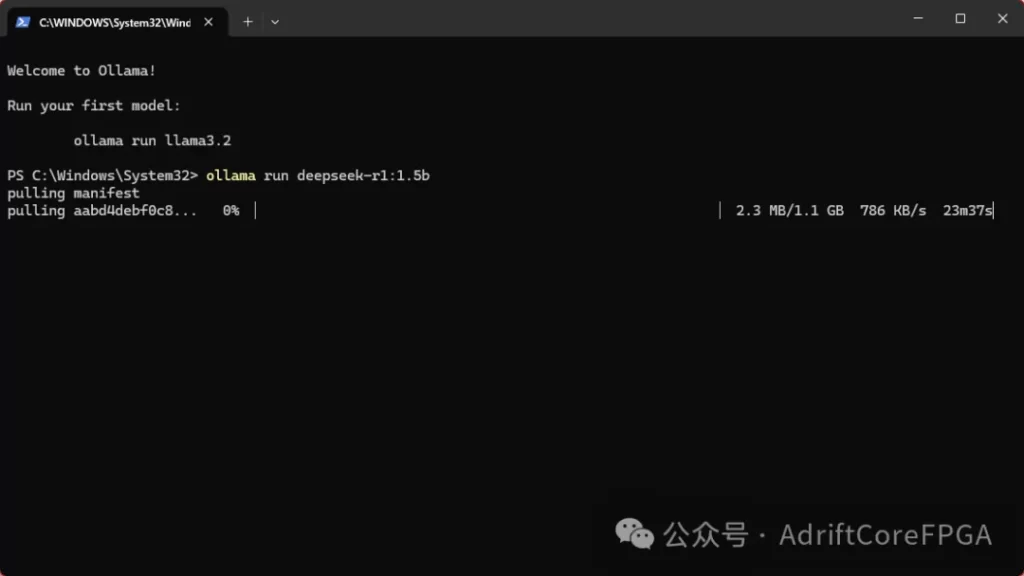

然后输入到cmd中:

ollama run deepseek-r1:1.5b

如果是7b,以此类推:

ollama run deepseek-r1:7b

需要等待一段时间下载

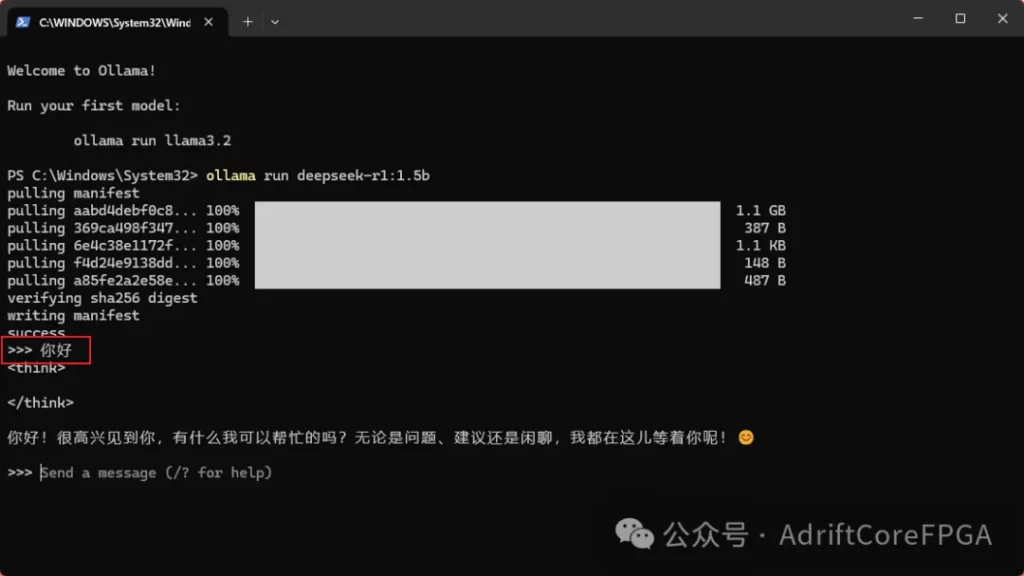

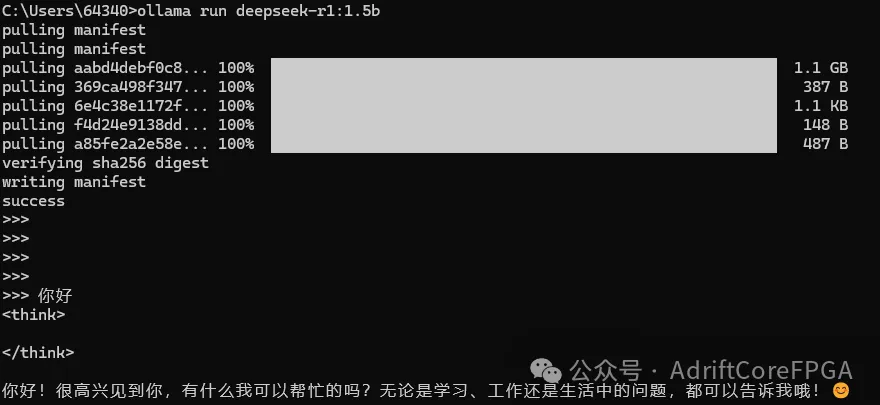

5 使用deepseek

打开cmd,输入所下版本同样的命令,则可以使用deepseek:

ollama run deepseek-r1:1.5b

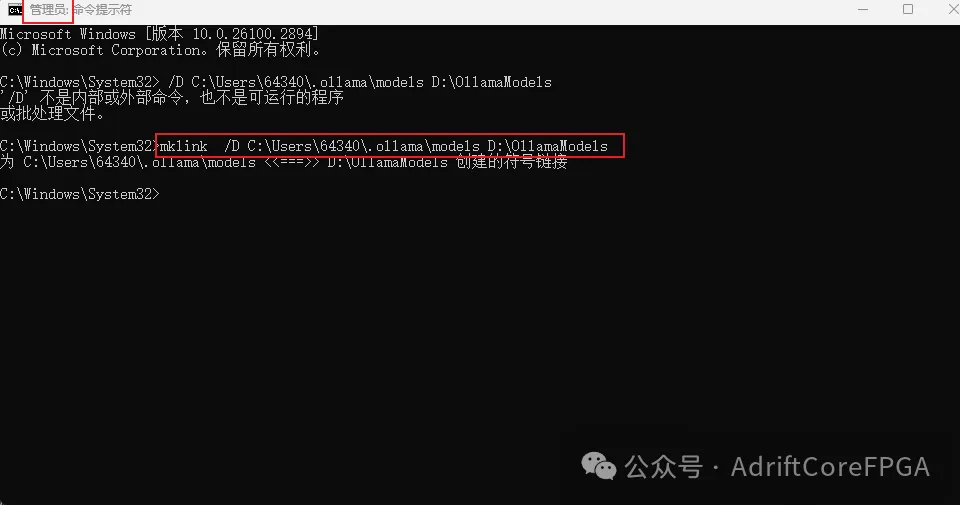

6 ollama大模型安装路径更改

如果我们使用windows系统安装,ollama默认安装在系统盘,而往往系统盘的容量不够大,我们可以将deepseek安装到其他盘中,但目前,ollama 本身并没有提供直接的、官方的选项来修改模型存储路径。我们可以使用符号链接的方式将对应文件夹链接到D盘文件夹,这样ollama读写文件只会读写对应D盘的链接文件夹。

首先,我们找到ollama模型的安装位置:

Linux/macOS: ~/.ollama/

Windows: C:\Users\<YourUser>\.ollama\

删除models文件夹:

在D盘创建一个新文件夹,如

D:\OllamaModels\

用管理员打开cmd,进行符号链接,然后再下载deepseek文件夹:

mklink /D C:\Users\<YourUser>\.ollama D:\OllamaModels

7 写在最后

本文主要介绍了 DeepSeek 的最简安装方法,后续将继续更新,介绍如何将 DeepSeek 集成到图形化界面中。