1 简介

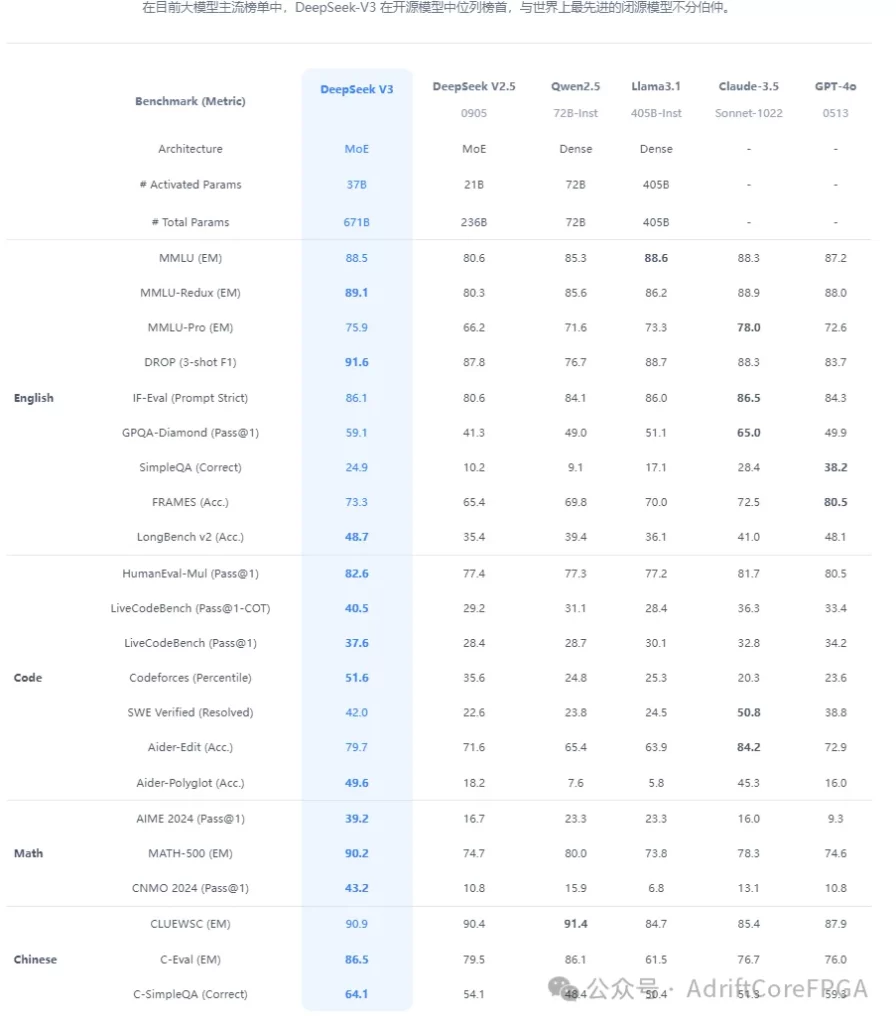

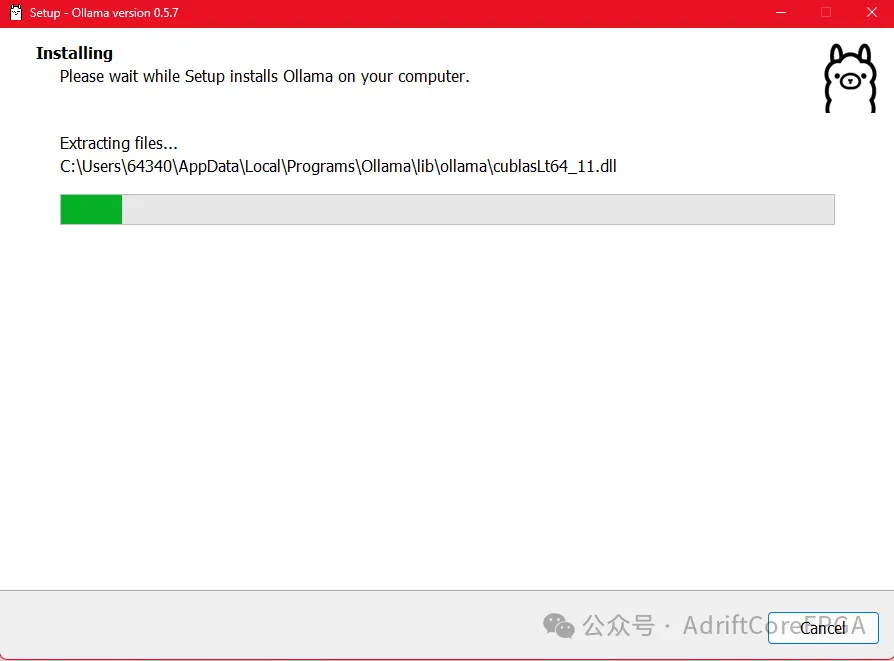

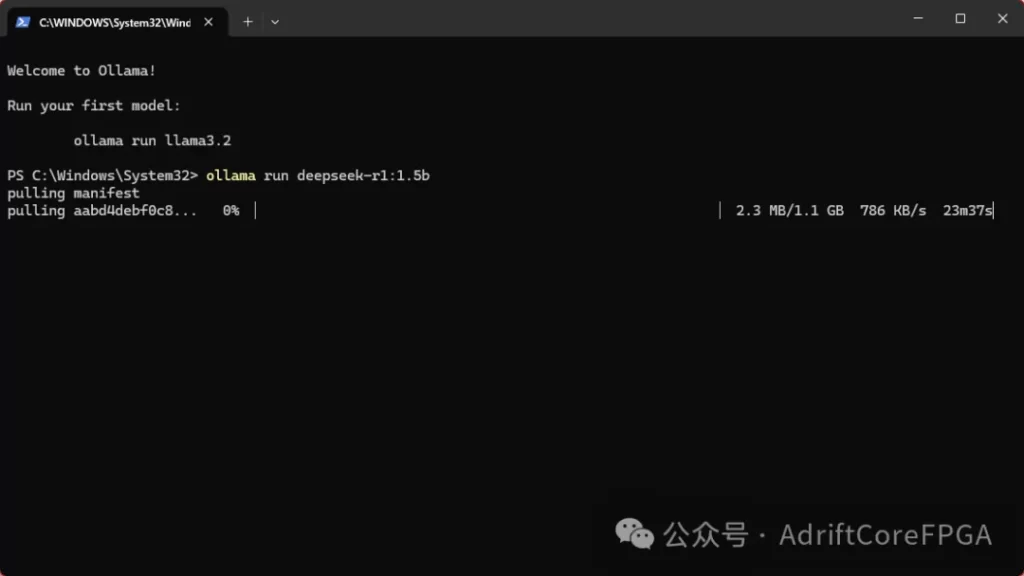

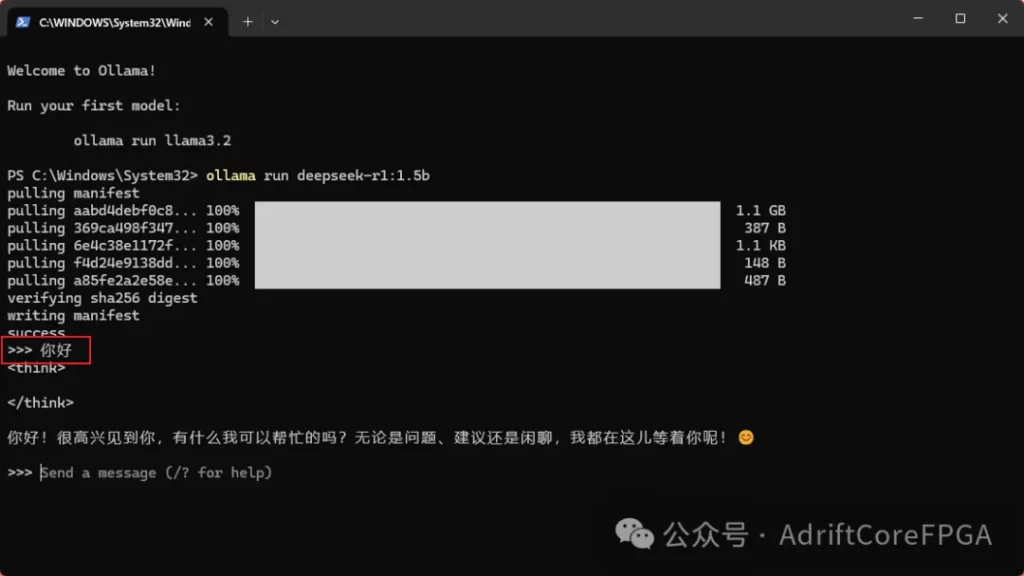

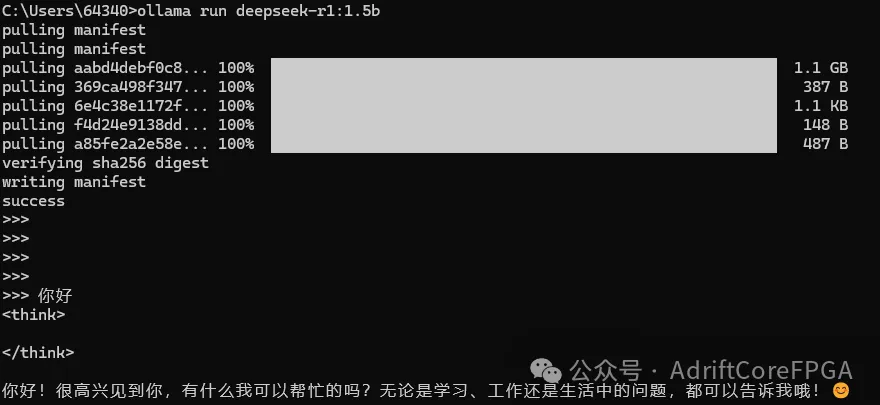

在上一篇推送中(deepseek本地部署最简教程),我们介绍了基于Ollama的本地部署。尽管本地化部署的DeepSeek模型在算力规模和功能完备性上无法媲美云端全量版本,但只要喂给它「独家秘方」——也就是你电脑里的文档、代码、笔记这些干货,它立马就能变身成你的专属知识小助手!

2 准备

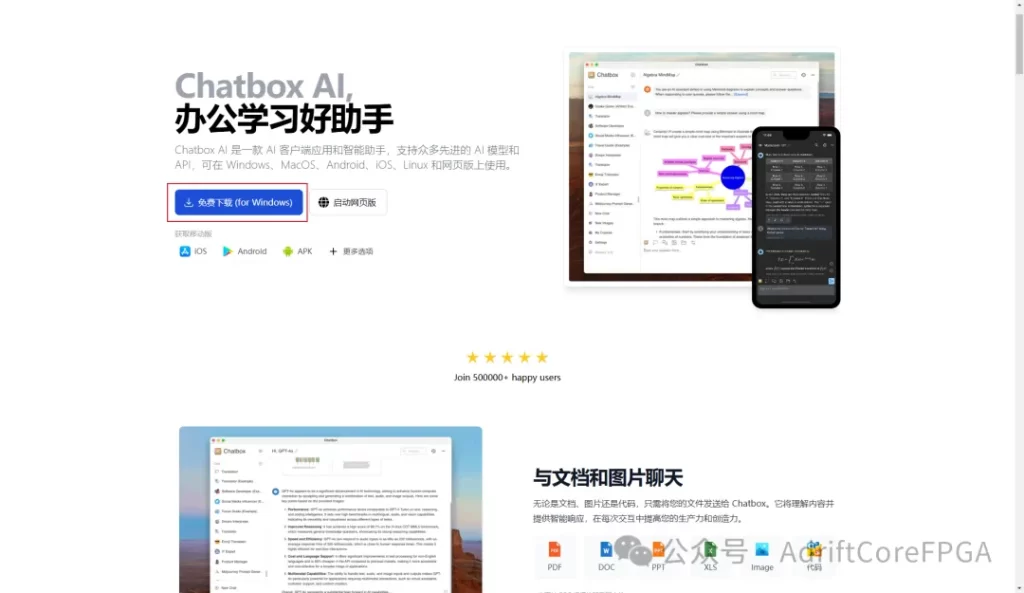

自己从头搭建个人知识库就像手工造汽车——理论可行但太费劲。这里推荐一个「懒人神器」:AnythingLLM。它能帮你把电脑里的文档(PDF/Word/代码文件都行)变成会聊天的知识库,操作就像把文件拖进文件夹一样简单!

用这个工具你可以:

✅ 随时提问:比如“上周写的Verilog代码在哪?”直接对话就能找到;写RTL代码卡壳时,它能秒查你去年写的相似案例;面对几十份会议纪要,直接问它就能提取关键结论。

✅ 保护隐私:所有资料都存在自己电脑里,不怕泄露

✅ 跨格式支持:无论是技术文档、会议记录还是代码片段都能处理

整个过程只需要三步:

把文件拖进软件

等它自动分析(喝杯咖啡的时间)

开始用自然语言提问

相当于给你的电脑配了个24小时待命的资料管家,特别适合经常需要查旧文档的技术人员!

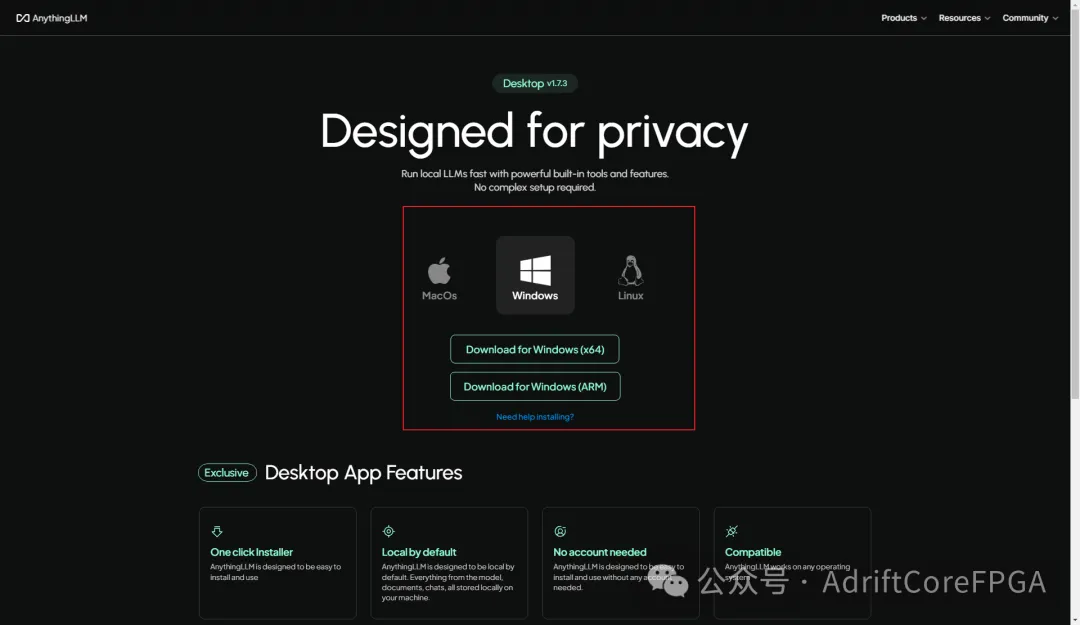

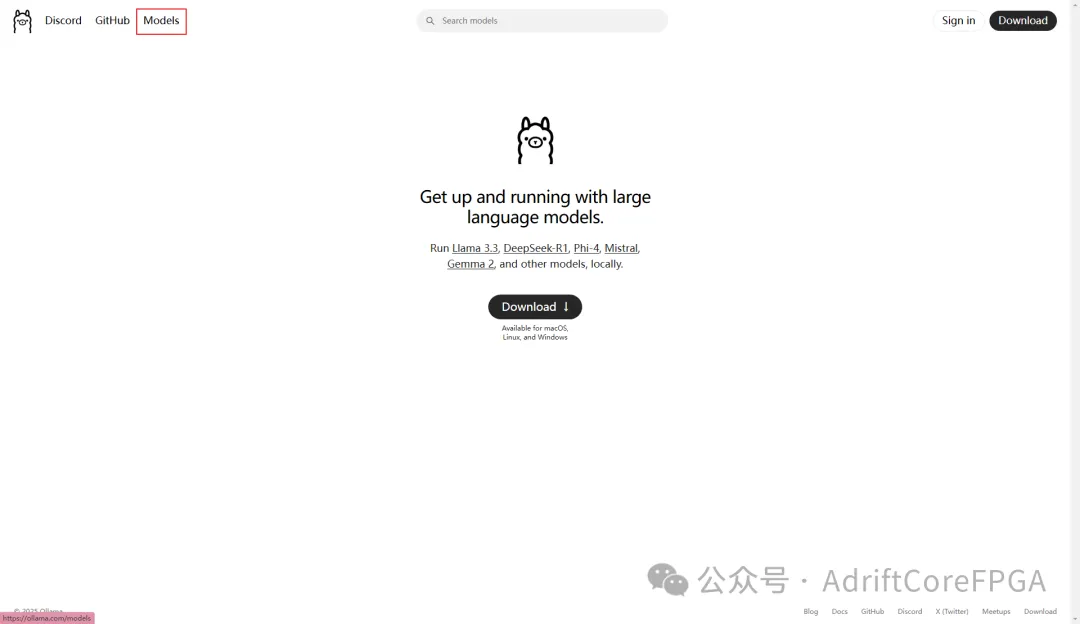

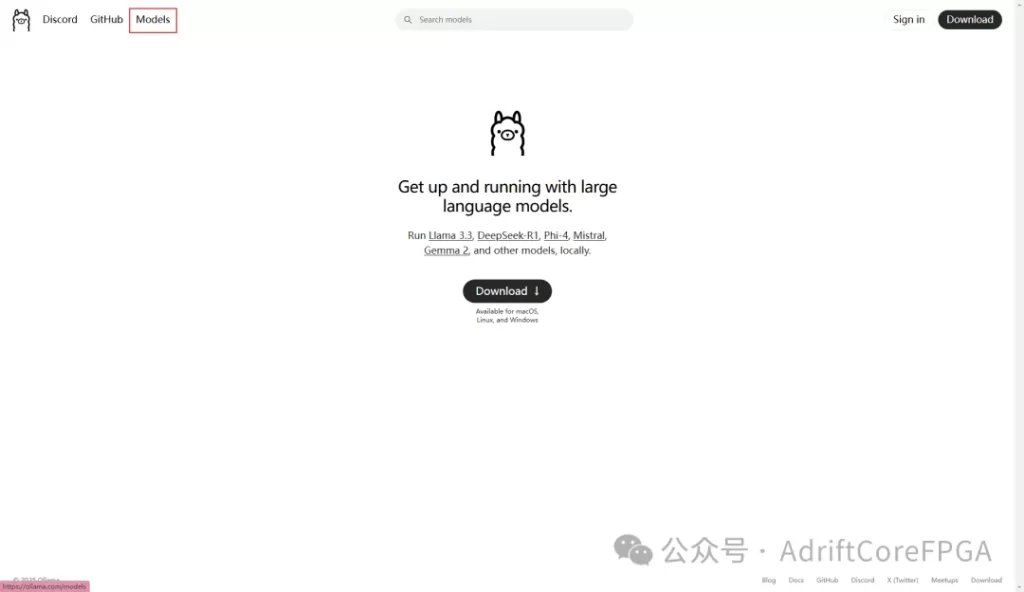

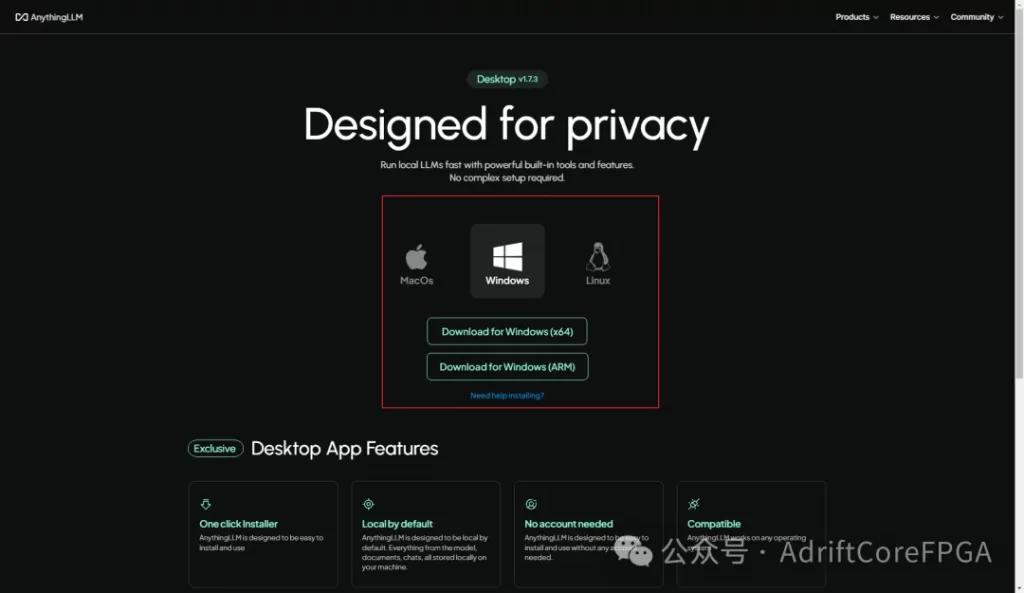

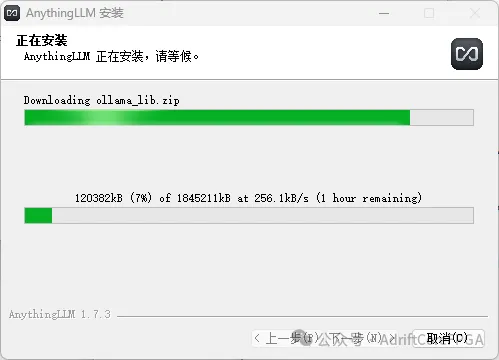

3 下载AnythingLLM

以下是下载链接:

https://anythingllm.com/desktop

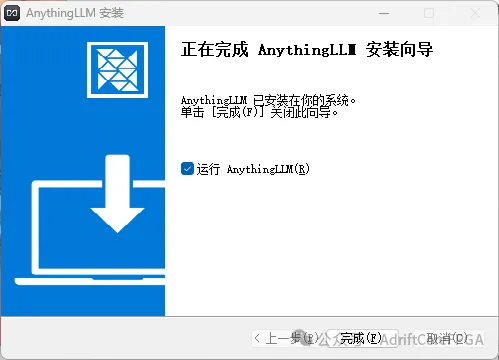

使用管理员模式安装

4 配置

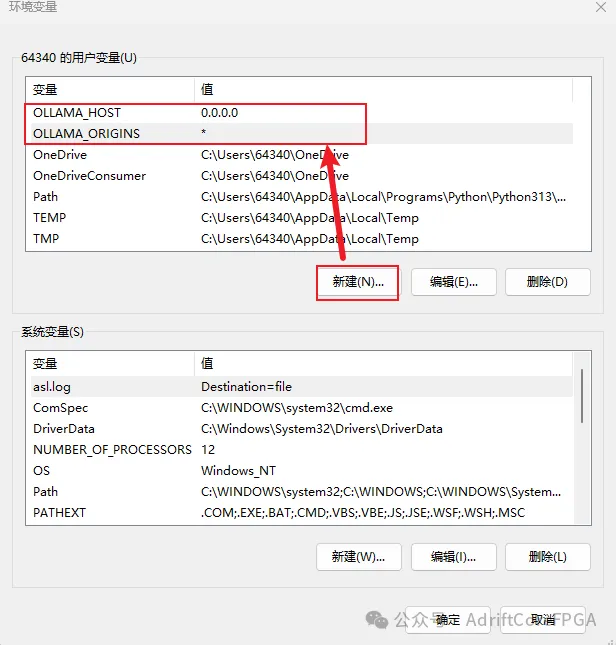

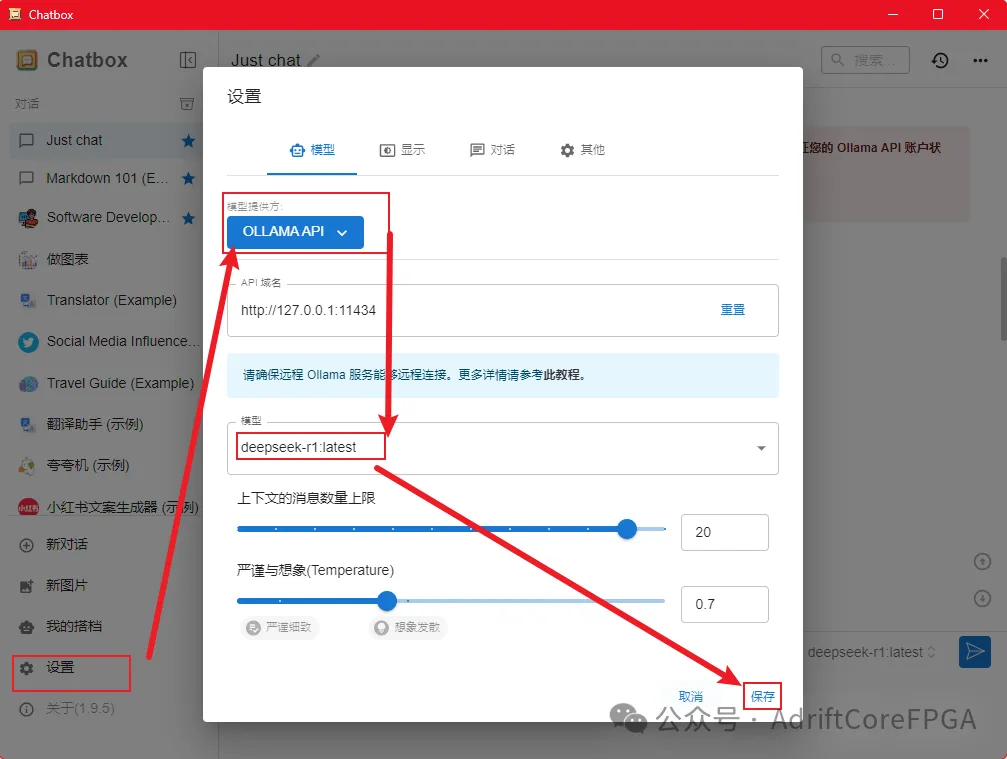

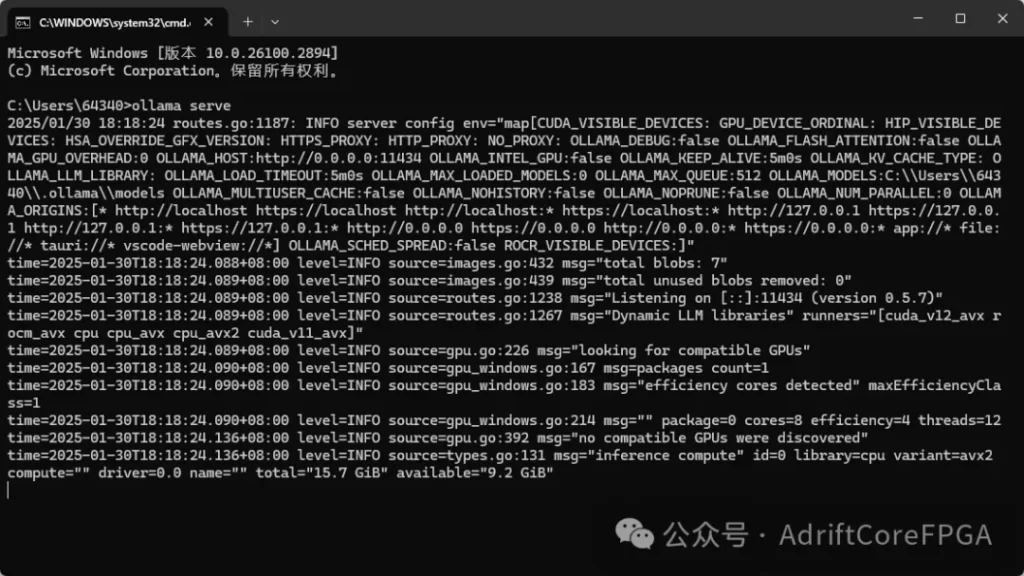

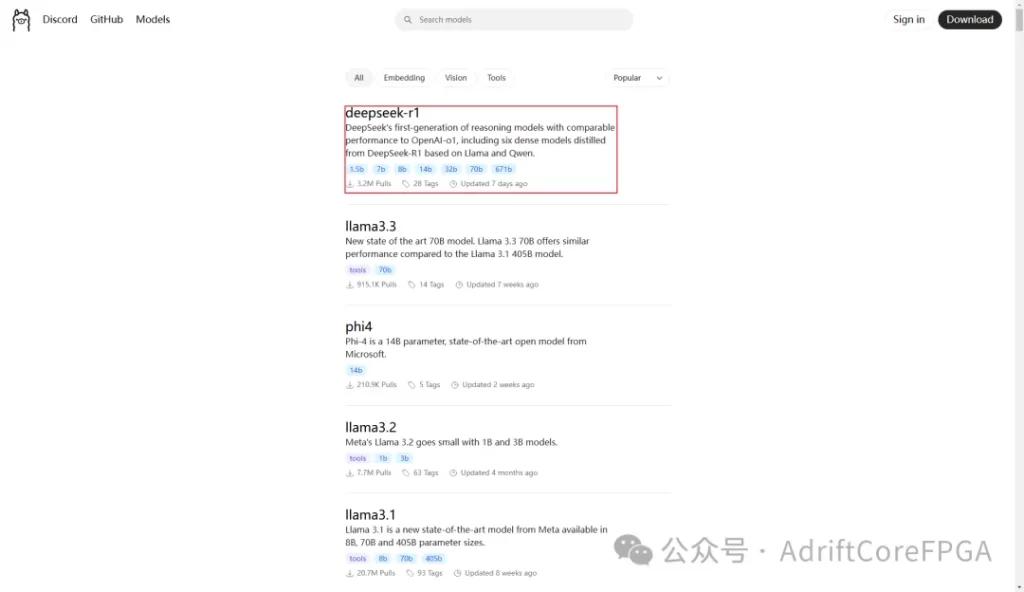

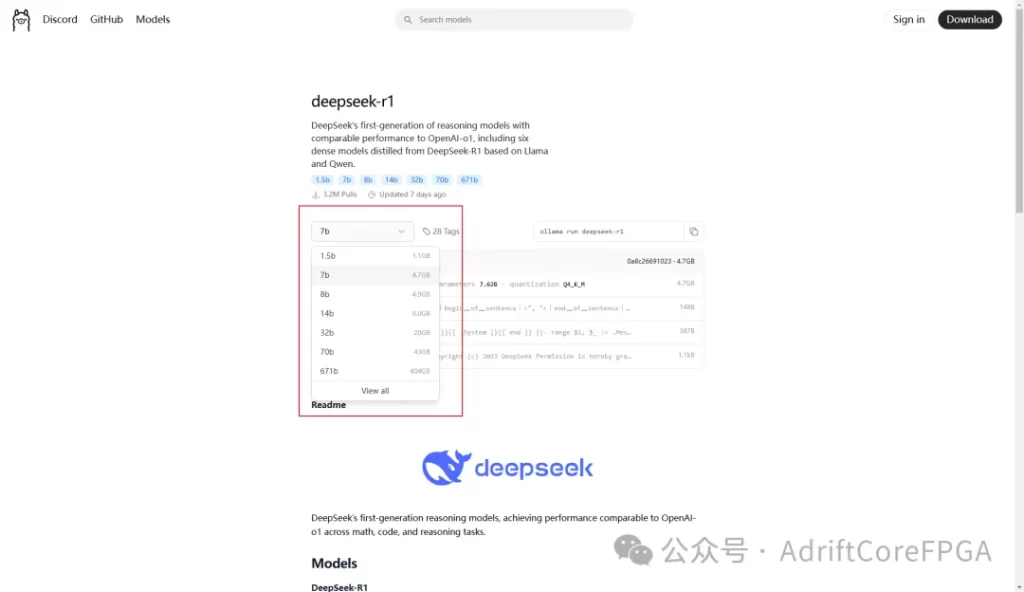

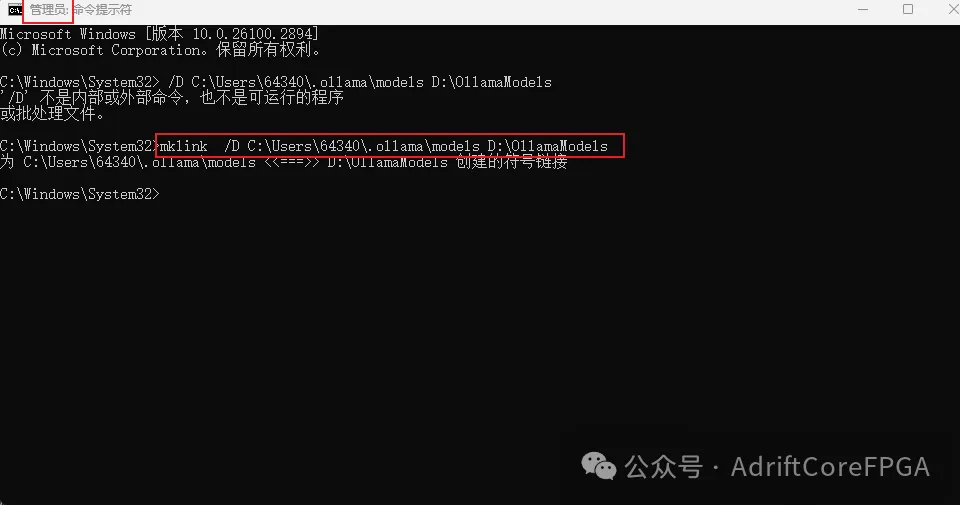

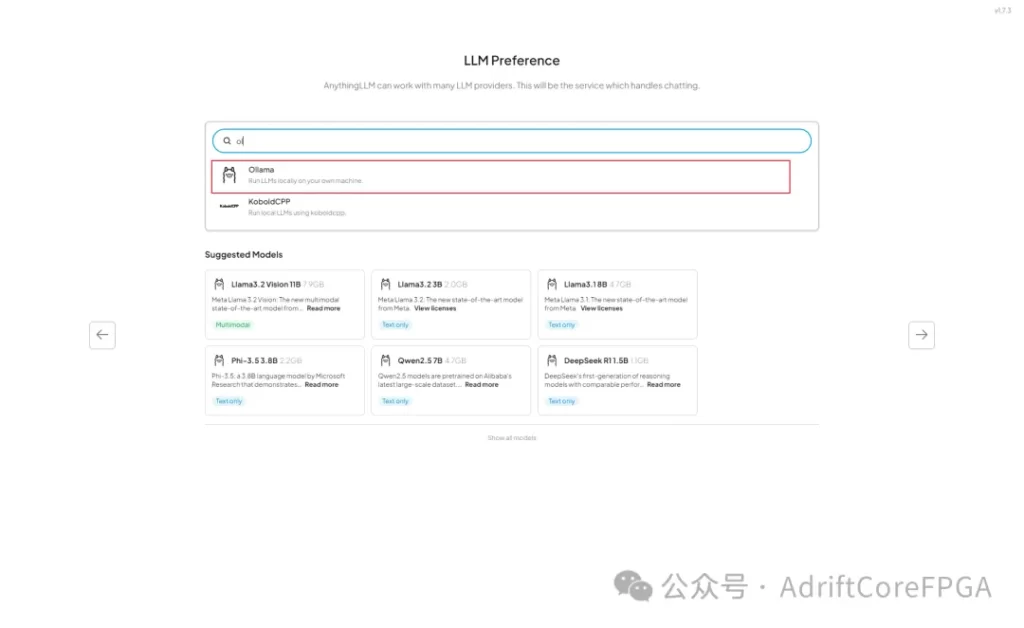

先确保ollama是开启状态,然后搜索ollama

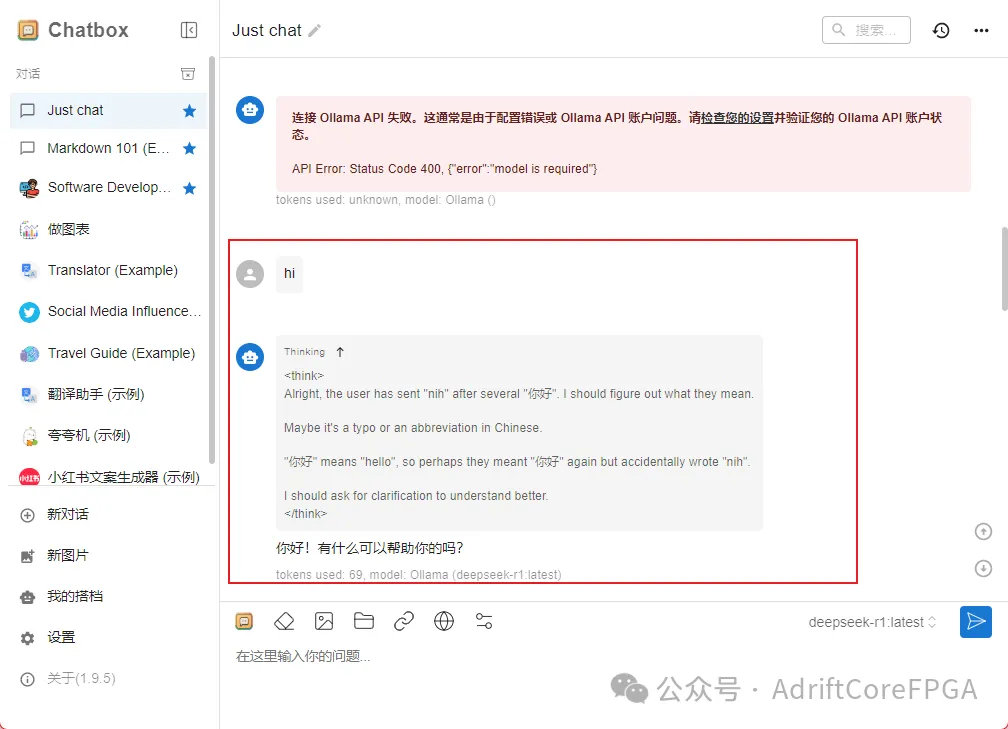

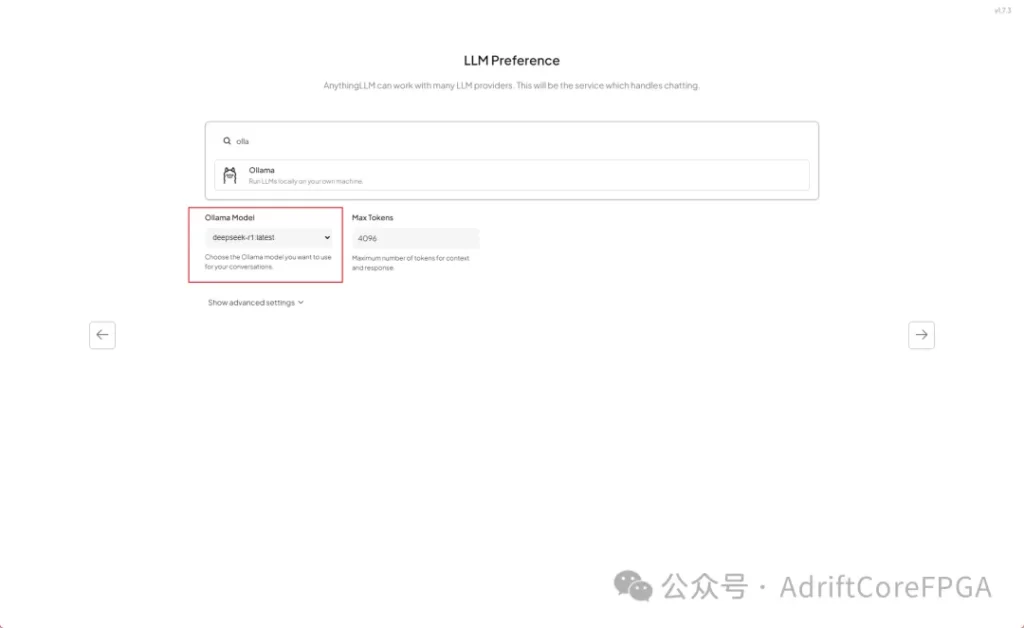

选择deepseek模型

在 AnythingLLM 的本地部署配置中,MAX Token(最大令牌数) 是一个关键参数,主要用于控制语言模型(LLM)处理文本时的输入和输出长度限制。

语言模型(如 GPT)单次处理的文本长度受硬件和算法限制。MAX Token 决定了模型单次请求能处理的 输入+输出 的 Token 总数上限。超过此值会导致截断或报错。

Token 并非严格等于单词或汉字。例如,英文中 1 Token ≈ 4 字符,中文中 1 汉字 ≈ 2-3 Token

在问答或生成场景中,该参数直接影响 AI 生成回答的最大长度。例如设置为 512,则回答内容会被限制在约 512 个 Token(约 380 个汉字或 700 英文单词)。

点击下一步

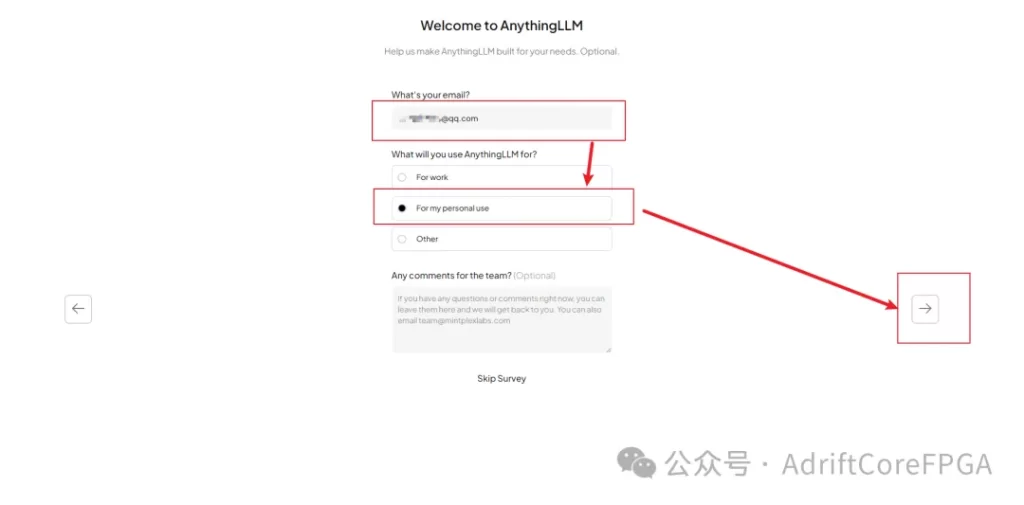

填写自己的邮箱

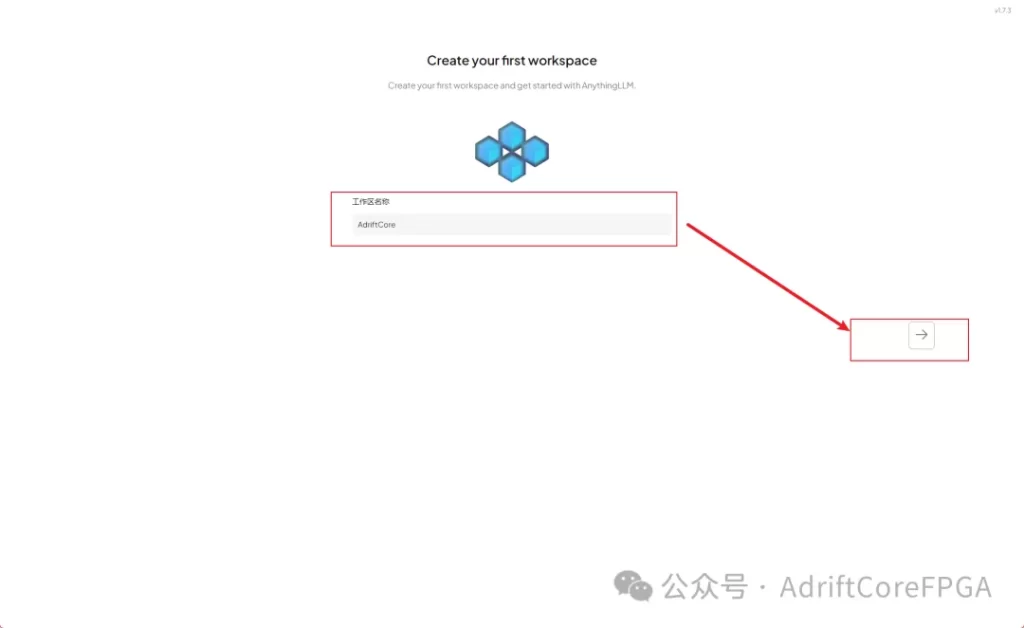

填写工作区名称

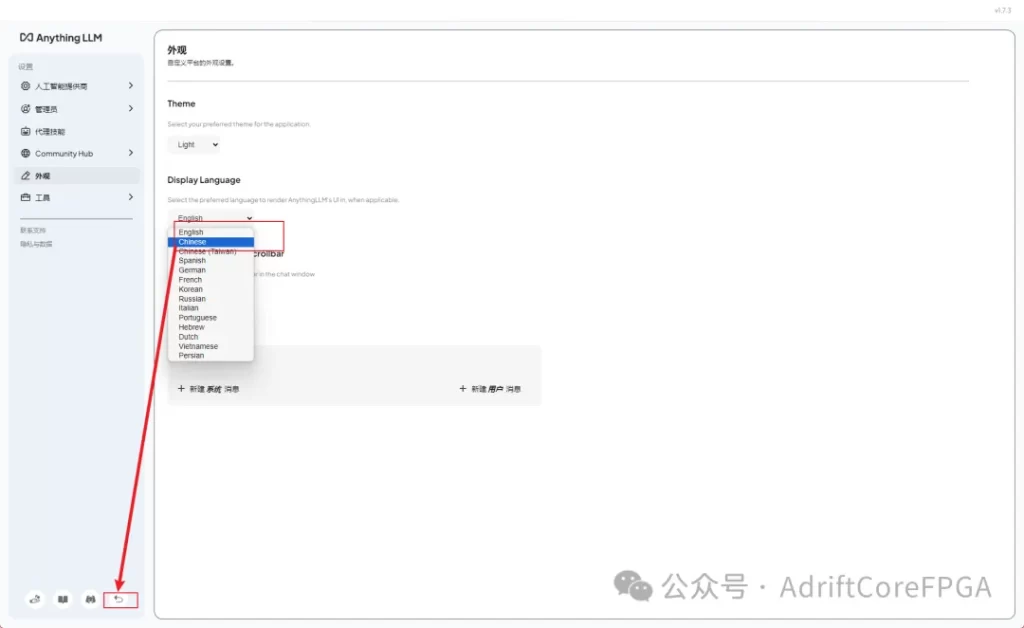

设置中文

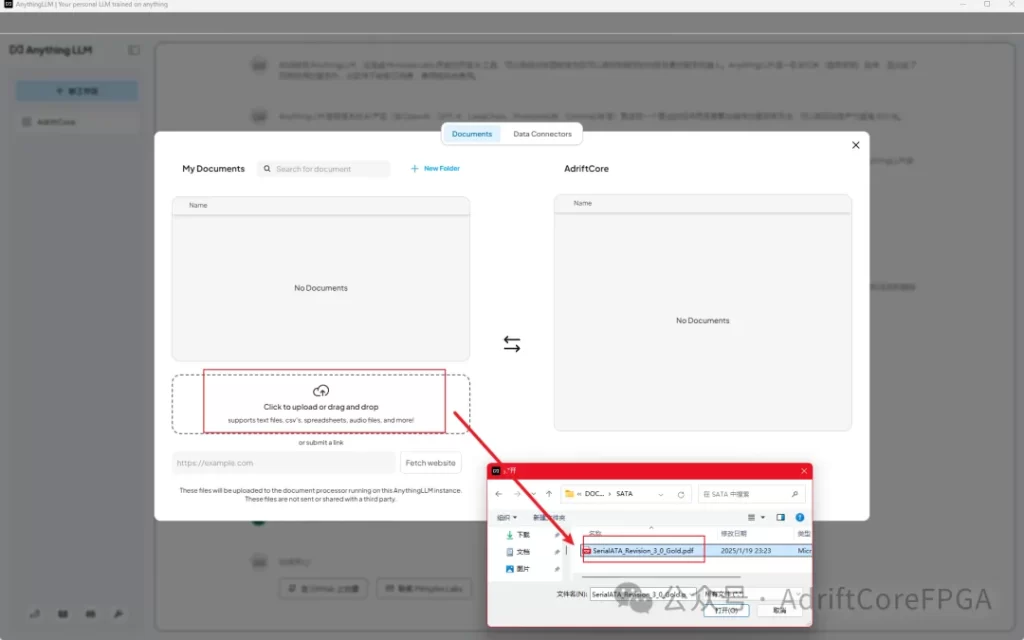

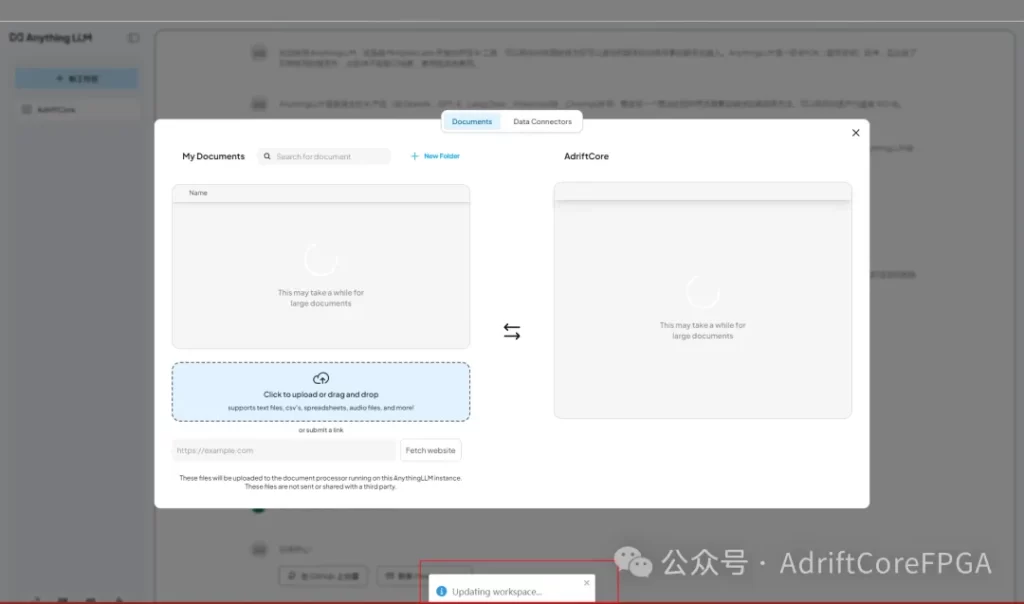

上传文档

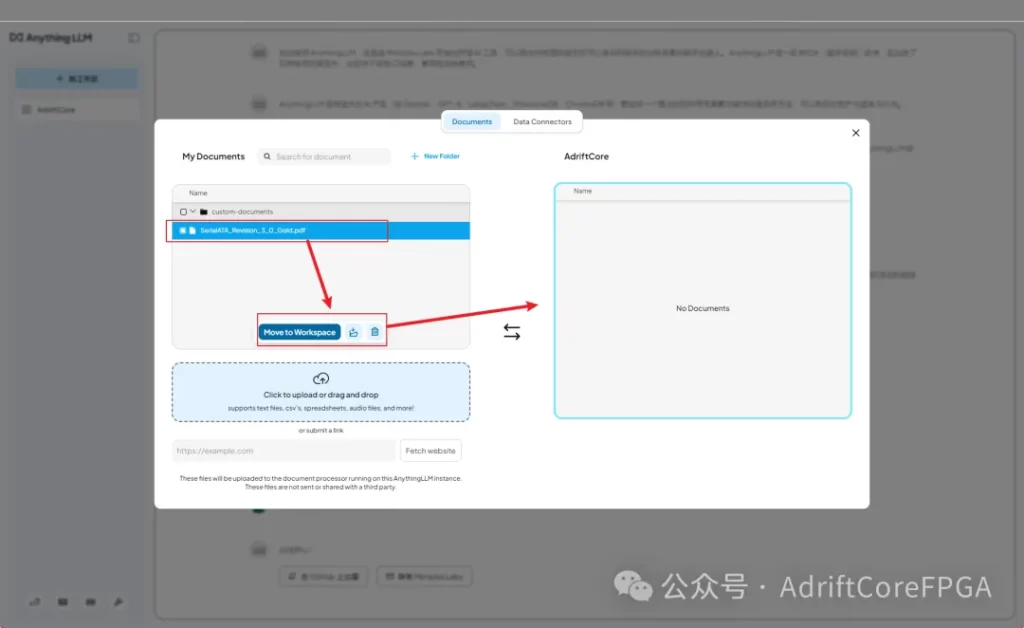

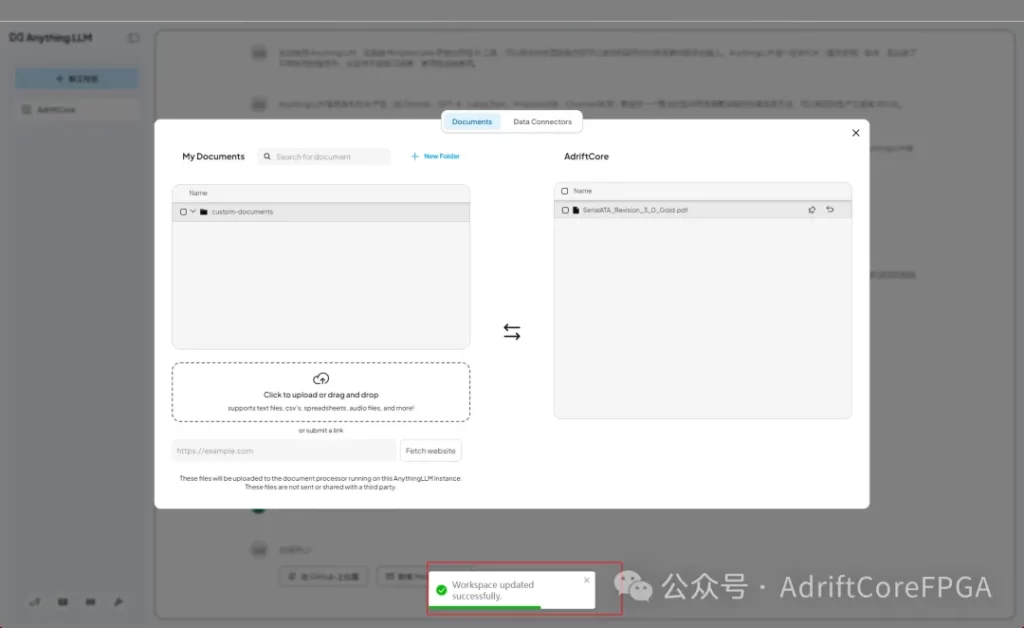

将文档放到工作区

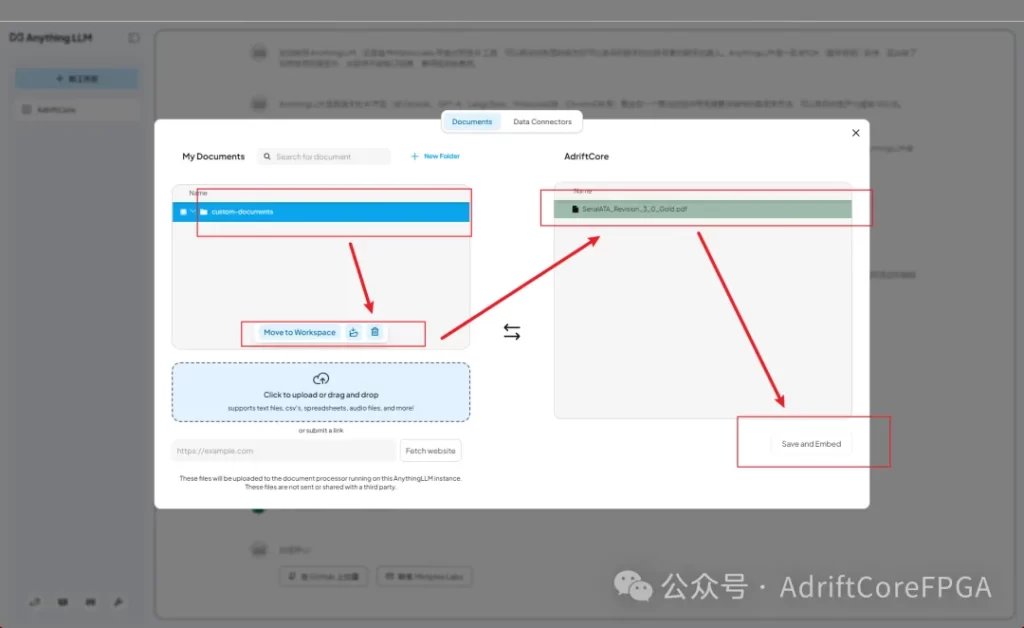

保存

更新中

更新成功

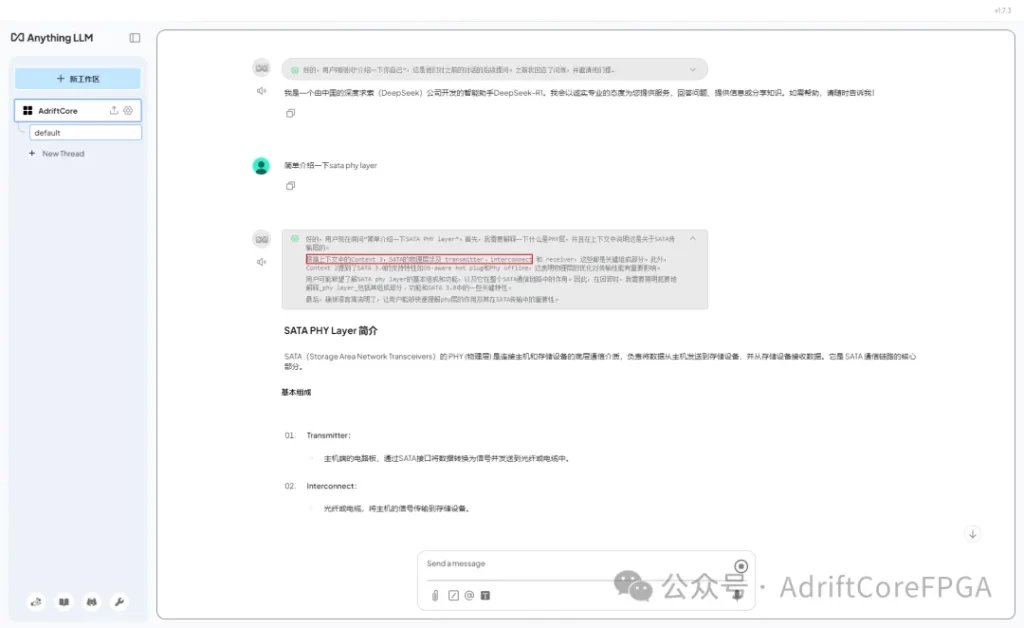

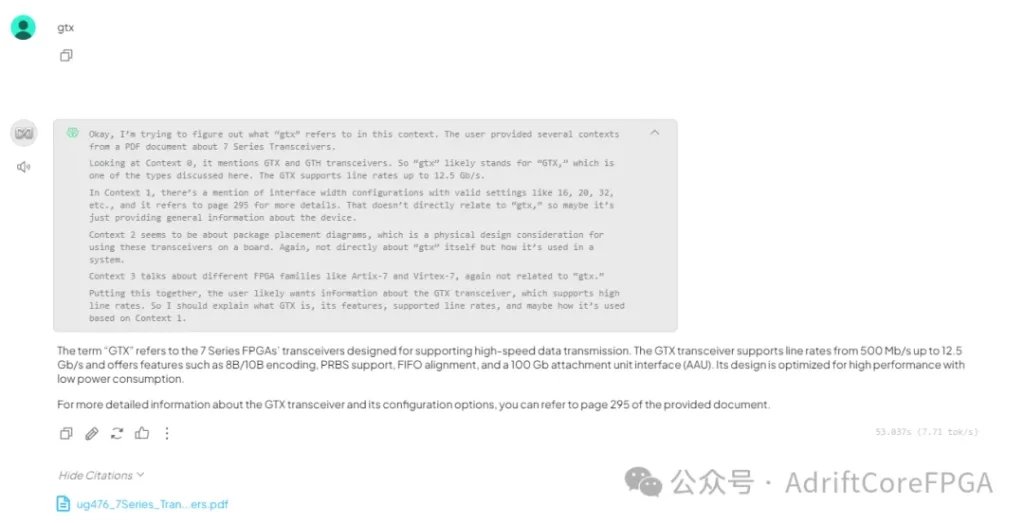

5 测试结果

可以看到deepseek可以理解文档中的内容

6 写在最后

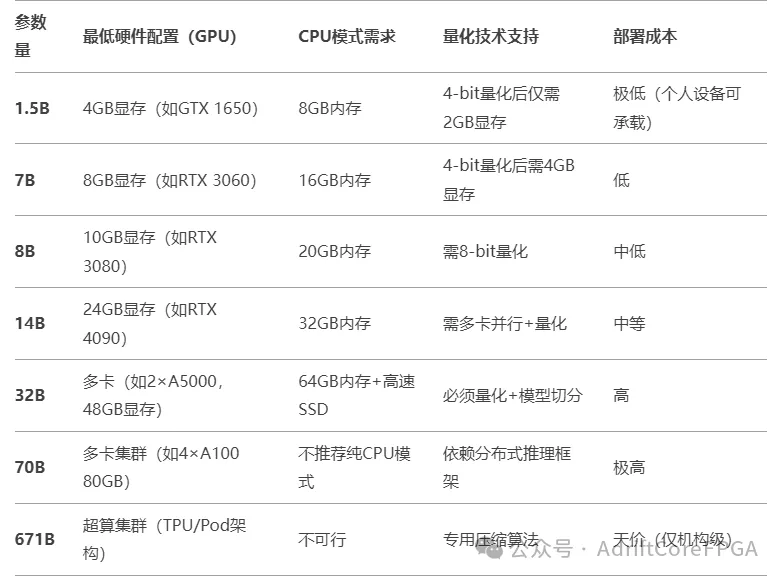

当然,AnythingLLM还具备其他功能,如代码托管和官方API的接入等,受篇幅所限,本文不再展开论述,各位可自行探索。需要注意的是,本地部署的AI回答精准度仍然受到硬件性能的制约。建议开发者参考以下硬件选型策略,轻量级部署:RTX 3060(12GB)+32GB DDR4+1TB SSD(支持7B参数模型实时推理);企业级方案:A100 80GB*4+NVLink+Optane持久内存(满足千亿级Token知识库毫秒响应)。