1 简介

在上一篇推送中(deepseek本地部署最简教程),我们介绍了基于Ollama的本地部署。然而,目前我们的对话仍需通过CMD进行操作,这在便捷性上有待提升。本期内容将采用GUI方式调用Ollama API,并实现完整的GUI对话功能。

2 为什么选择ollama

先回答之前读者的问题,为什么选择ollama而不是lm studio,对于不同需求的用户,可自行选择:

非技术用户/快速验证:无脑选LM Studio

开发者/需自定义模型:选Ollama,虽然初期配置复杂,但后续可扩展性强(支持API、Docker等)

3 安装chatbox

Chatbox AI 是一款桌面客户端应用,旨在为用户提供更便捷、高效的方式与 AI 交互。以下是下载链接:

https://chatboxai.app/

4 配置环境变量

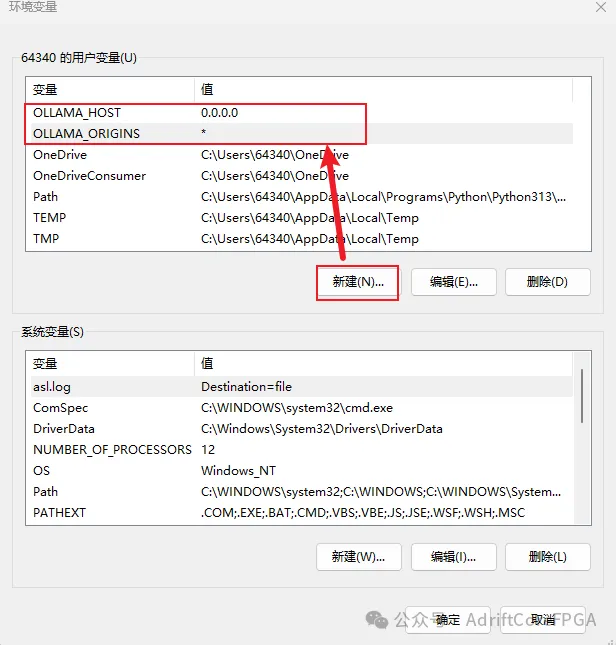

OLLAMA_HOST 和 OLLAMA_ORIGINS 是 Ollama 的配置环境变量,用于配置 Ollama 与其 API 服务器之间的通信。

OLLAMA_HOST,用于指定 Ollama 服务监听的主机地址和端口。默认情况下,Ollama 会绑定到 127.0.0.1:11434(仅本地访问)。通过修改此变量,可以实现以下场景:

允许其他设备通过局域网访问 Ollama。

在 Docker 容器或云服务器中运行时,开放对外访问。

我们可以配置为0.0.0.0, 表示开放到所有IP,允许所有网络接口访问

OLLAMA_HOST=0.0.0.0:11434

OLLAMA_ORIGINS,用于控制 Ollama API 的跨域请求来源(CORS)。默认情况下,Ollama 仅允许同源请求(即与 API 同域名/端口)。若需要从其他域名或端口调用 API(例如通过自定义 Web 前端),需通过此变量指定允许的来源。

# 示例:允许特定域名或端口OLLAMA_ORIGINS=http://localhost:3000,https://example.com

我们可以配置为*, 表示允许所有来源

OLLAMA_ORIGINS=*

至于windows如何配置用户环境变量,可自行百度或bing搜索

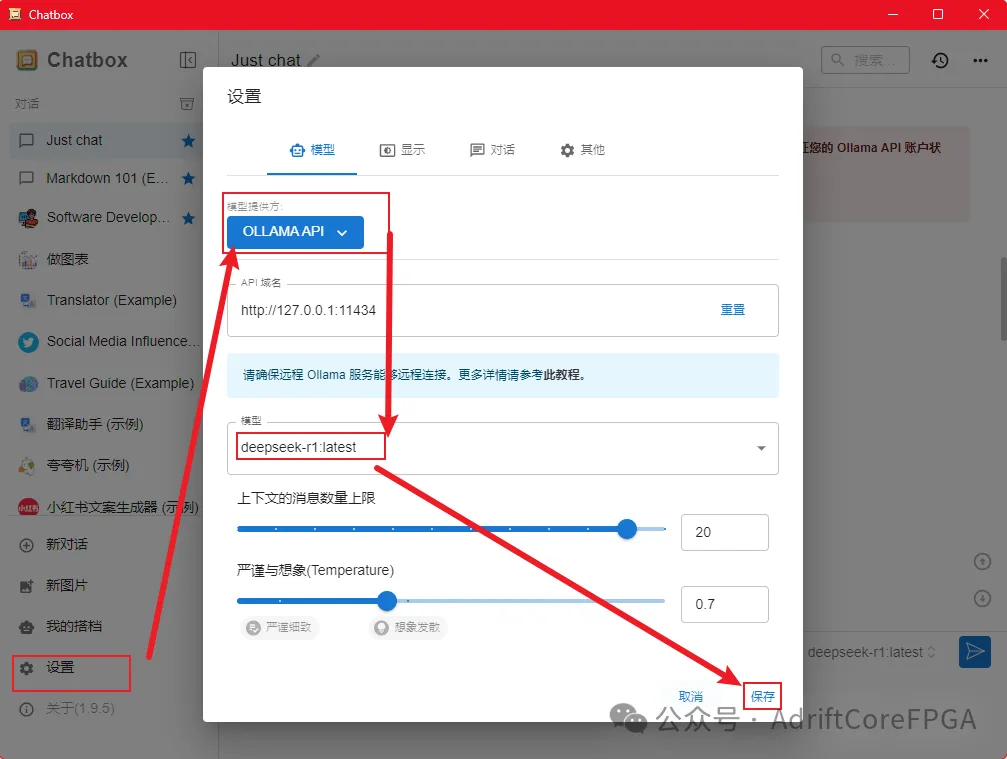

5 配置ChatBox

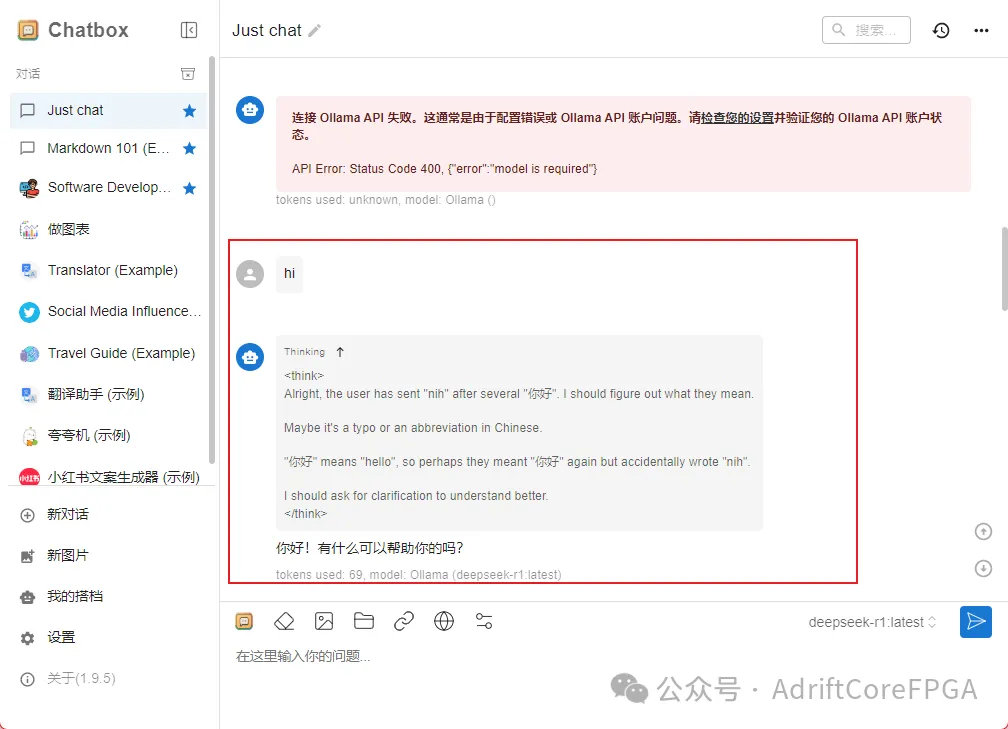

打开ChatBox,选择模型提供方OLLAMA API,选择对应的模型deepseek r1

6 测试

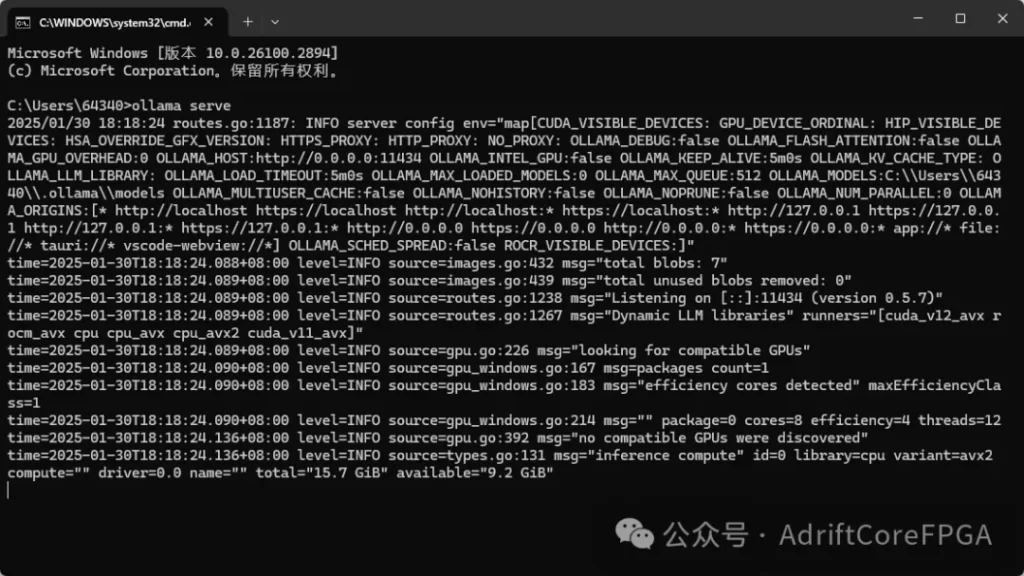

如果我们之前打开过ollama,需要先关掉(一般在右下角图标中)

然后,打开cmd运行以下命令,启动ollama服务:

ollama serve

之后,我们就可以使用gui来进行对话了

7 写在最后

无论是DeepSeek,还是ChatGPT,作为先进的生产工具,如果能够合理有效地运用,都能对我们的工作和学习产生极大的帮助。它们不仅能够提升工作效率,减少重复性劳动,还能够帮助我们更好地解决问题、拓宽思维和提高创新能力。特别是在快速变化的时代,掌握和利用这些工具,不仅能让我们在专业领域中保持竞争力,也能为个人成长和知识积累提供强有力的支持。

但需强调的是,真正的价值创造仍需以人类的专业判断力为前提——保持批判性思维,善用提示词工程精准表达需求,将AI输出与专业知识体系深度融合,方能实现从工具应用到认知升级的质变。

发表回复